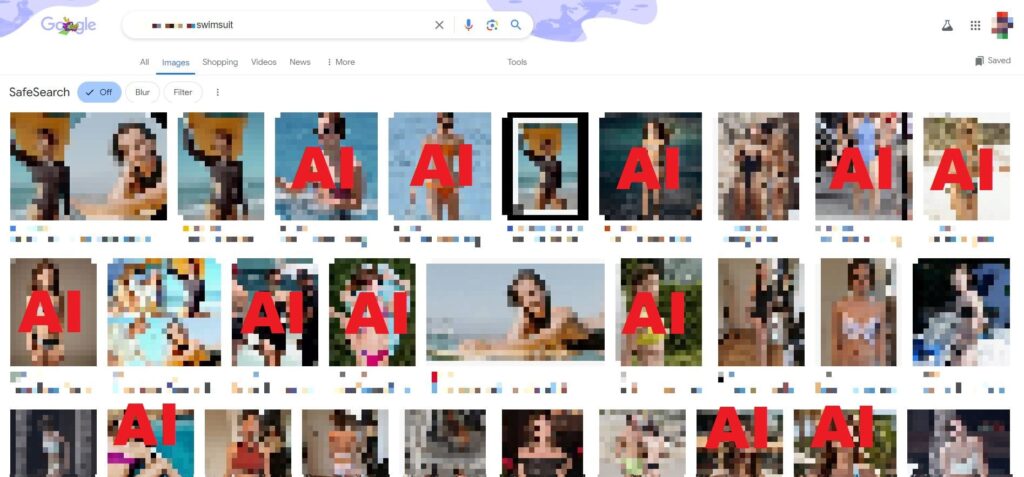

De zoekresultaten van Google voor afbeeldingen tonen door AI gegenereerde afbeeldingen van beroemdheden en leiden gebruikers naar sites waar door AI gegenereerde naaktfoto’s van beroemdheden worden gehost die eruitzien als kinderen.

Google Afbeeldingen zoeken biedt gebruikers AI-gegenereerde afbeeldingen van beroemdheden in zwemkleding en geeft niet aan dat de afbeeldingen door AI zijn gegenereerd. In enkele gevallen, zelfs als de zoektermen er niet expliciet om vragen, levert Google Image Search door AI gegenereerde afbeeldingen van beroemdheden in zwemkleding, maar de beroemdheden worden gemaakt om op minderjarige kinderen te lijken.

Als gebruikers op deze afbeeldingen klikken, worden ze naar sites voor het genereren van AI-afbeeldingen geleid, en in een aantal gevallen leiden de aanbevelingsmotoren op deze sites gebruikers naar door AI gegenereerde niet-consensuele naaktfoto’s en door AI gegenereerde naaktfoto’s van beroemdheden die op kinderen lijken. .

Het nieuws is het zoveelste voorbeeld van hoe de tools die mensen al tientallen jaren gebruiken om op internet te navigeren, overweldigd worden door de stroom van door AI gegenereerde inhoud, zelfs als ze er niet om vragen, en die vrijwel uitsluitend zonder toestemming gebruik maken van het werk of de beeltenis van mensen. Soms maakt de stortvloed aan AI-inhoud het voor gebruikers moeilijk om onderscheid te maken tussen wat echt is en wat door AI is gegenereerd.

Ik ontdekte dat Google Image Search dit volledig per ongeluk deed. Jason deed verslag van zijn verhaal over hoe fanpagina’s van Taylor Swift en andere beroemdheden op Facebook zijn overgenomen door bestialiteit en oplichting, en we probeerden te controleren of een afbeelding van Taylor Swift die haar tong uitsteekt door AI werd gegenereerd of bewerkt. Om het te vinden, typte ik de zoekterm ’taylor Swift beach zonnebril tong uit’, waardoor een aantal door AI gegenereerde afbeeldingen op het Google-tabblad voor het zoeken naar afbeeldingen terechtkwamen.

Eén, afkomstig van een Japanse Pinterest-pagina die een aantal andere door AI gegenereerde afbeeldingen van Swift bevatte, zag er redelijk realistisch uit. De andere, afkomstig van een site voor het genereren van AI-afbeeldingen genaamd Neural Love, bevatte een aantal typische door AI gegenereerde misvormingen en was duidelijk nep.

Omdat beide resultaten op de eerste pagina stonden (de door AI gegenereerde afbeelding van Swift in de auto is momenteel het derde resultaat), wilde ik controleren of Google-afbeeldingen die zoeken naar namen van beroemdheden plus de term ‘badpak’ of ‘bikini’ consequent zouden veranderen door AI gegenereerde afbeeldingen.

Over het geheel genomen heb ik deze methode getest met 13 namen van vrouwelijke beroemdheden, waaronder enkele van de beroemdste mensen ter wereld en enkele minder bekende YouTubers en Twitch Streamers, en elke Google Image-zoekopdracht indexeerde door AI gegenereerde afbeeldingen van hen, ook al deed de zoekterm dat wel. omvat geen ‘AI’.

Een zoektocht naar twee beroemdheden leverde ook AI-gegenereerde afbeeldingen op van hen in zwemkleding, maar dan als kinderen, ook al bevatte de zoekopdracht geen termen die verband hielden met leeftijd.

“Onze geautomatiseerde systemen streven ernaar om de hoogste kwaliteit en meest relevante afbeeldingen weer te geven voor de miljarden zoekopdrachten die we elke dag ontvangen”, vertelde een woordvoerder van Google mij in een e-mail. “Gezien de schaal van het open web zijn er gevallen waarin onze classificatiesystemen relevante webinhoud naar voren kunnen brengen die helaas niet voldoet aan onze kwaliteitsnormen. We gebruiken deze voorbeelden om algemene verbeteringen aan te brengen, terwijl we prioriteit blijven geven aan inspanningen om te voorkomen dat inhoud van lage kwaliteit – inclusief door AI gegenereerde inhoud van lage kwaliteit – hoog in de zoekresultaten verschijnt.”

De woordvoerder zei dat Google Search honderden miljarden pagina’s en afbeeldingen op internet indexeert, en hoewel er tools bestaan om door AI gegenereerde afbeeldingen op deze schaal betrouwbaar te identificeren, bevinden deze zich nog in de kinderschoenen en zijn ze niet onfeilbaar. De woordvoerder gaf aan dat Google het beter zou kunnen doen door AI-afbeeldingen te labelen die met zijn eigen generator zijn gemaakt, zoals beschreven in deze bedrijfsblog .

Google reageerde niet op specifieke vragen over waarom het door AI gegenereerde inhoud in de zoekresultaten naar voren bracht, en we kunnen niet met zekerheid zeggen wat er gebeurt, maar het is gemakkelijk voor te stellen waarom “geautomatiseerde systemen” deze afbeeldingen naar boven zouden halen. De afbeeldingen zijn altijd gelabeld met de namen van de beroemdheden en aanvullende termen als ‘bikini’, ‘badpak’ of ‘badpak’.

Omdat deze afbeeldingen afkomstig zijn van sites voor het genereren van AI-afbeeldingen, bevatten ze vaak ook de tekstprompts waarmee ze zijn gemaakt, waardoor een soort gedetailleerde annotatie wordt geboden voor wat er in de afbeelding staat. Ten slotte zijn deze sites voor het genereren van AI-afbeeldingen populair, en het is gemakkelijk voor te stellen dat mensen op nooit eerder vertoonde foto’s van Taylor Swift in badpak klikken (omdat deze niet echt zijn), waardoor deze mogelijk hoger in de zoekresultaten terechtkomen.

Als u op een van deze afbeeldingen klikt in de zoekresultaten van Google voor afbeeldingen, worden gebruikers naar deze sites voor het genereren van AI-afbeeldingen geleid, waar ze tientallen vergelijkbare door AI gegenereerde afbeeldingen te zien krijgen.

Toen ik bijvoorbeeld op een door AI gegenereerde afbeelding klikte van een beroemdheid in een zwempak dat eruitzag als een kind, werd ik naar Playground.com geleid, een site die AI-afbeeldingen genereert, waar ik nog tientallen afbeeldingen van dezelfde beroemdheid te zien kreeg. in kindervorm, in badpak, evenals tientallen andere door AI gegenereerde afbeeldingen van kinderen in badpak.

Een paar van de afbeeldingen hadden de titel ‘[naam van de beroemdheid] op Epstein Island in bikini’, verwijzend naar Little Saint James, een privé-eiland eigendom van Jeffery Epstein, waar hij werd beschuldigd van kinderhandel en seksueel misbruik.

Door op een andere door AI gegenereerde afbeelding van een beroemdheid te klikken die eruit ziet als een kind in een zwempak, worden gebruikers naar een site genaamd sdxlturbo.ai geleid. Onder die afbeelding bevinden zich een aantal andere afbeeldingen van kinderberoemdheden in zwemkleding, en een paar door AI gegenereerde afbeeldingen van topless beroemdheden die op kinderen lijken. De prompt die een van deze beelden opleverde is: “[naam van de beroemdheid] op 8-jarige leeftijd, zeer gespierde buikspieren, haar buik laten zien, aan het baden.”

Gezien de manier waarop de aanbevelingsengine werkt op deze sites voor het genereren van AI-afbeeldingen, stuurt het klikken op een van deze afbeeldingen gebruikers in een konijnenhol met meer afbeeldingen van dezelfde soort. De resultaten herinneren er ook nog eens aan dat door AI gegenereerde CSAM niet alleen op het dark web of andere moeilijk toegankelijke hoeken van het internet wordt geproduceerd en gedeeld, maar gemakkelijk toegankelijk is op AI-tools en -platforms, ondanks het beleid van deze platforms, en gewoonweg toegankelijk is via AI-tools en -platforms. een paar klikken verwijderd van een Google-zoekopdracht.

De door AI gegenereerde afbeeldingen van beroemdheden die in de zoekresultaten van Google verschijnen, zijn meestal afkomstig van een handvol sites voor het genereren van AI-afbeeldingen: Lexica, Neural Love, Prompt Hunt, Night Cafe en ook Deviantart, dat geen tool voor het genereren van afbeeldingen heeft, maar waar mensen door AI gegenereerde afbeeldingen hosten. Het inhoudsbeleid voor deze sites varieert, voor zover ik ze kon vinden, maar verbiedt over het algemeen niet-consensuele pornografie en CSAM. Dat betekent niet dat het beleid perfect wordt gehandhaafd.

Playground bijvoorbeeld, waar momenteel verschillende door AI gegenereerde afbeeldingen worden gehost van beroemdheden als kinderen in badpak op ‘Epstein-eiland’, heeft een inhoudsbeleid dat ‘inhoud opsomt die kinderen afbeeldt op een manier die de aantrekkingskracht of seksualisering van hen aanmoedigt of bevordert’, zoals “onaanvaardbaar gebruik.”

“Als je twijfels hebt over inhoud in deze categorie, moet je hiervan afzien”, zegt de inhoudsbeleidpagina van Playground . “Er bestaat geen perfecte heldere lijn, dus voor alles in het grijze gebied zullen we conservatief matigen. Als richtlijn: jonge meisjes/jongens/tieners in hun bikini/beha/ondergoed zijn problematisch (het is zelfs nog erger als je de kleding negatief vraagt) Het is onwaarschijnlijk dat iets dat ‘uitpuilt’ de test doorstaat;

Ik kon geen pagina met inhoudsbeleid vinden, sdxlturbo.ai, die momenteel door AI gegenereerde afbeeldingen bevat van naakte beroemdheden die op kinderen lijken, of Lexica, waar een snelle zoekopdracht een door AI gegenereerd, niet-consensueel naakt van een beroemdheid opleverde.

Over het geheel genomen zag ik dat Google door AI gegenereerde afbeeldingen van beroemdheden van elf verschillende sites voor het genereren van AI-afbeeldingen haalde. Lexica en sdxlturbo.ai hebben niet gereageerd op een verzoek om commentaar.

De woordvoerder van Google zei dat Google, naast zijn wettelijke verplichtingen, een productbeleid heeft dat bepaalt wanneer inhoud uit de zoekresultaten wordt verwijderd. Google zegt dat het zoekresultaten blokkeert die leiden naar beelden van seksueel kindermisbruik of materiaal dat kinderen tot slachtoffer lijkt te maken, in gevaar brengt of anderszins uitbuit. De woordvoerder van Google zei dat het bedrijf geen commentaar kan geven op eventuele acties tegen specifieke sites, maar ik heb niet gemerkt dat een van de sites die in dit verhaal worden genoemd, wordt geblokkeerd in de zoekresultaten nadat ik ze bij Google heb gemarkeerd.

404 Media heeft het afgelopen jaar gerapporteerd over de manier waarop AI, en met name door AI gegenereerde afbeeldingen, het internet hebben overspoeld. Jason heeft meerdere artikelen geschreven over hoe AI-gegenereerde slop Facebook heeft gezombificeerd , en ik heb me geconcentreerd op een paar sites voor het genereren van afbeeldingen, zoals Mage.Space , Tensor.Art (die ook verschijnt in de zoekresultaten van Google voor afbeeldingen), en vooral Civitai , wat een cruciale hulpbron is voor de scène voor het genereren van AI-afbeeldingen, omdat het ook aangepaste modellen voor het genereren van afbeeldingen host.

Dit is echter slechts een fractie van een snelgroeiende industrie van AI-beeldgeneratiesites die het internet overspoelen en overweldigen. We hebben gezien hoe deze door AI gegenereerde afbeeldingen Facebook volledig hebben veranderd, en omdat inhoud voor volwassenen vaak een goede vroege indicator is voor waar het internet naartoe gaat, kun je je gemakkelijk voorstellen hoe door AI gegenereerde afbeeldingen het zoeken naar afbeeldingen op Google kunnen veranderen zoals wij dat kennen. ook.