kunstmatige intelligentie – Terwijl Barbie-mania de wereld in zijn greep houdt, verdient het pittige culturele icoon dank voor het helpen illustreren van een duistere kant van AI

Velen zijn enthousiast over de manieren waarop kunstmatige intelligentie ons leven kan verbeteren. Elke ontwikkeling die mensen de mogelijkheid geeft om zich op een nieuwe manier uit te drukken, is opwindend, en de snelheid waarmee AI-tools worden gefinancierd, gemaakt en ingezet, heeft deze systemen bijna voordat we met onze ogen konden knipperen, mainstream gemaakt.

Maar velen zijn ook bang voor mogelijke schade als deze technologie mainstream wordt, inclusief hoe het wordt gebruikt om bestaande ongelijkheden te verergeren die hele gemeenschappen schaden – zoals toen Buzzfeed onlangs afbeeldingen publiceerde van 194 door kunstmatige intelligentie gegenereerde Barbie-poppen , waarvan vele onnauwkeurige en kwetsende culturele stereotypen in stand houden die dat niet waren gevangen voor publicatie.

Deze bias vindt niet plaats in een vacuüm. De aard van uitvoer zoals deze kunstmatige intelligentie Barbie-afbeeldingen hangt af van de trainingsgegevens van het systeem, het trainingsmodel en de keuzes die de menselijke makers tijdens het proces maken. Het oude gezegde “garbage in, garbage out” geldt nog steeds.

AI-systemen moeten enorme hoeveelheden gegevens krijgen om te werken, en zullen de meest voorkomende vooroordelen in die gegevens “leren”. Deze gegevens, gebaseerd op het open schrapen van het web, zullen de neiging hebben om de meest dominante stemmen na te praten, vaak ten koste van minderheden en gemarginaliseerde identiteiten.

Het oude gezegde “garbage in, garbage out” geldt nog steeds. AI-systemen moeten enorme hoeveelheden gegevens krijgen om te werken, en zullen de meest voorkomende vooroordelen in die gegevens “leren”.

De door kunstmatige intelligentie gegenereerde Barbies zijn een zeer visueel en visceraal voorbeeld van waarom kunstmatige intelligentie niet zou moeten worden gebruikt om meer impactvolle beslissingen in ons leven te nemen, zoals huisvesting, werk, medische zorg of scholing – een levendige illustratie die laat zien hoe deze tools ontstaan met ingebakken maatschappelijke vooroordelen .

Bovendien, in een wereld waar rijke landen muren bouwen rond de toegang tot en de ontwikkeling van AI-systemen, leveren mensen in landen als Kenia essentiële maar slecht betaalde arbeid bij het bouwen van deze systemen. Ondanks dat het is gebouwd op de arbeid van deze mensen, bevordert de resulterende kunstmatige intelligentie alleen hun uitbuiting en machteloosheid.

Een AI-tool kan bijvoorbeeld standaard afbeeldingen van blanke mensen genereren, raciale ongelijkheid versterken of zich oriënteren op een lichtere huid als reactie op verzoeken om “mooie” mensen. Afbeeldingen van vrouwen worden eerder als seksueel van aard gecodeerd dan afbeeldingen van mannen in vergelijkbare kledingstijlen en activiteiten, vanwege de wijdverbreide culturele objectivering van vrouwen in deze afbeeldingen en de bijbehorende tekst.

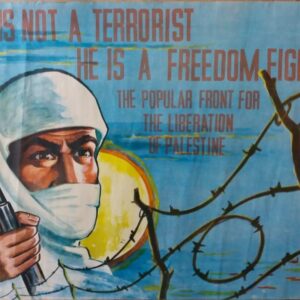

Al deze vooroordelen kwamen duidelijk naar voren in de AI-Barbiepoppen: de overseksualisering van poppen die het Caribisch gebied vertegenwoordigen, oorlogsideeën voor bepaalde landen in het Midden-Oosten, onnauwkeurige culturele kleding uit Azië en een wereldwijde uitroeiing van inheemse gemeenschappen.

Dingen worden bijzonder nijpend wanneer deze verhulde logica wordt gebruikt om levensveranderende beslissingen te nemen. Rechtshandhaving, medische zorg, scholen en werkplekken wenden zich allemaal tot de zwarte doos van AI om beslissingen te nemen, bijvoorbeeld met voorspellende politietools , die zijn gebouwd op een basis van notoir onnauwkeurige en bevooroordeelde misdaadgegevens .

Deze tools witten bevooroordeelde politiegegevens om tot bevooroordeeld politiewerk – waarbij algoritmen de nadruk leggen op buurten die al overbemand zijn. Dit witwassen van vooroordelen komt weer naar voren bij het bepalen van borgtocht in contanten , het aannemen van een baan , huisvesting of zelfs sociale uitkeringen en asiel. Zelfs zonder de objectiviteit van kunstmatige intelligentie in twijfel te trekken, kan deze vooringenomenheid discriminerende en pseudowetenschappelijke claims witwassen, zoals voorspellen of iemand een crimineel is op basis van de vorm van hun gezicht .

Rechtshandhaving, medische zorg, scholen en werkplekken wenden zich allemaal tot de zwarte doos van AI om beslissingen te nemen, bijvoorbeeld met voorspellende politietools, die zijn gebouwd op een fundament van notoir onnauwkeurige en bevooroordeelde misdaadgegevens.

Dus wat gebeurt er als – en waarschijnlijker wanneer – deze beslissingen “verkeerd” zijn? Hoe kan een slachtoffer dat bewijzen, en wie is juridisch en ethisch verantwoordelijk? Dit zijn nog te beantwoorden vragen.

AI zonder menselijke input is niet te vertrouwen, en dit is vooral belangrijk gezien het feit dat het vaak de gemeenschappen zijn die het meest worden beïnvloed door schadelijke vooroordelen die de minste toegang hebben tot de ontwikkeling van en het toezicht op deze AI-systemen.

Beschouw dit debacle in de context van de huidige stakingen van de Writers Guild of America en SAG-AFRA : Geautomatiseerde systemen produceren output die over het algemeen van lage kwaliteit is – en zonder menselijke bijdragers zoals redacteuren en bedachtzame schrijvers zullen we onnauwkeurige, aanstootgevende en schadelijke AI zien creaties sluipen ons medialandschap binnen.

Het zijn vaak gemeenschappen die het meest worden beïnvloed door schadelijke vooroordelen die de minste toegang hebben tot de ontwikkeling van en het toezicht op deze AI-systemen.

De oplossing is om het voorbeeld van security research en open science te volgen. Door deze nieuwe tools op een open en controleerbare manier te ontwikkelen, kunnen we meer kennis delen en op een transparante manier gegevens verzamelen. Het zou onderzoekers in verschillende contexten helpen deze vooroordelen aan te pakken en een effectief systeem van kunstmatige intelligentie bieden dat schrijvers kan helpen , in plaats van te functioneren als een slechte vervanging van schrijvers van lage kwaliteit.

Dit zou het voor de aspirant-subjecten ook mogelijk maken om hun eigen systemen te creëren en de weergave van hun afbeeldingen en gemeenschappen daarin te veranderen – uiteindelijk doorbreken van onderdrukkende machtsonevenwichtigheden. kunstmatige intelligentie kan correct en rechtvaardig worden uitgevoerd, maar dit moet de erosie van uitbuitende gegevensverzameling omvatten om ervoor te zorgen dat iedereen hiervan profiteert .

We moeten deze gegevens terugwinnen en de kracht ervan benutten om tools te bouwen voor een betere wereld – misschien te beginnen met betere AI-gegenereerde Barbie-poppen.