De mogelijkheden van machines om nepvideo’s van mensen te maken zijn schrikbarend indrukwekkend geworden. ByteDance, de Chinese techgigant achter TikTok, heeft zojuist een nieuw systeem voor kunstmatige intelligentie gedemonstreerd, genaamd OmniHuman-1. Hiermee kan het deepfakevideo’s maken die voor de gemiddelde persoon bijna niet van de werkelijkheid te onderscheiden zijn.

Misschien zijn we de unheimliche vallei al lang voorbij. De nepvideo’s van OmniHuman-1 zien er indrukwekkend realistisch uit en de deepfakeresultaten van het model zijn misschien wel de meest realistische tot nu toe. Kijk maar eens naar deze TED Talk die nooit heeft plaatsgevonden.

Het systeem heeft slechts één foto en een audio-opname nodig om deze video’s helemaal opnieuw te maken. U kunt ook elementen zoals verhoudingen en omlijsting aanpassen. AI kan zelfs bestaand videomateriaal aanpassen, bijvoorbeeld lichaamsbewegingen en gebaren op een angstaanjagend realistische manier bewerken.

Natuurlijk zijn de resultaten niet 100% perfect. Sommige houdingen zien er wat ongemakkelijk uit, zoals dit ongemakkelijke voorbeeld van het vasthouden van een wijnglas.

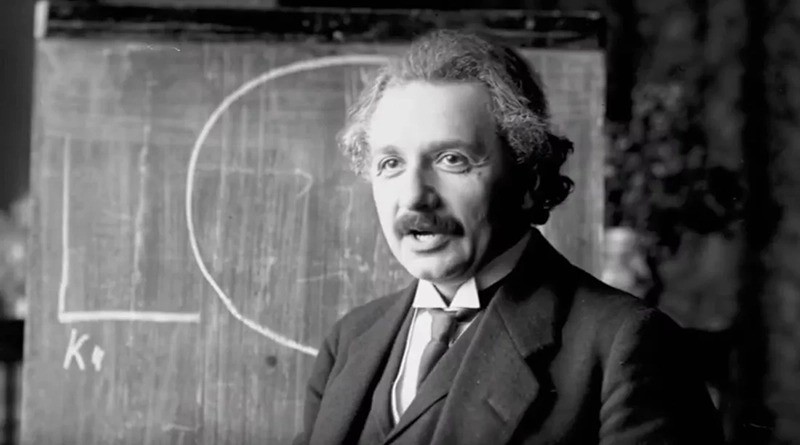

Er is ook een Einstein-college dat door kunstmatige intelligentie is nagebootst, waarbij zijn handen in vreemde richtingen draaien. Zijn gezicht is echter bijna perfect weergegeven.

Ook wij hebben jou steun nodig in 2025, gun ons een extra bakkie koffie groot of klein.

Dank je en proost?

Wij van Indignatie AI zijn je eeuwig dankbaar

De algehele kwaliteit is echter veel beter dan die van eerdere deepfake-methoden.

Onder de motorkap trainde OmniHuman-1 op 18.700 uur aan videodata met behulp van een nieuwe ‘alle omstandigheden’-benadering waarmee het tegelijkertijd van meerdere invoerbronnen kan leren, zoals tekstuele signalen, audio en lichaamshoudingen. Volgens onderzoekers van ByteDance helpen deze bredere trainingsgegevens de AI om “dataverlies aanzienlijk te verminderen” in vergelijking met oudere deepfake-modellen.

De gevolgen van deze technologie zijn zorgwekkend. Deepfakes zijn de afgelopen jaren al gebruikt als wapen voor desinformatiecampagnes, fraude en allerlei duistere doeleinden. Tijdens de verkiezingscampagne van 2024 vonden er veel incidenten plaats waarbij deepfakes van audio en video werden verspreid met als doel kiezers te misleiden.

Ook vorig jaar kostte financiële fraude mensen miljarden. Een bekend geval betreft een oplichter die met behulp van kunstmatige intelligentie (AI) de identiteit van Brad Pitt nabootste en vorige maand een vrouw ertoe verleidde om 850.000 dollar over te maken.

Naar aanleiding van deze gevallen hebben honderden experts op het gebied van AI-ethiek vorig jaar opgeroepen tot regelgeving voor deepfakes. Verschillende Amerikaanse staten hebben al wetten aangenomen tegen kwaadaardige deepfakes, maar er is nog steeds geen algemene wetgeving op federaal niveau.

Californië stond bijvoorbeeld op het punt een wet aan te nemen die rechters de mogelijkheid geeft om mensen te dwingen deepfakes te verwijderen en hen mogelijk een boete te bezorgen als ze zulke foto’s posten. Het wetsvoorstel is echter vastgelopen in het wetgevingsproces.

ByteDance heeft OmniHuman-1 nog niet uitgebracht voor het grote publiek, maar u kunt wel een artikel over het model lezen.