De anatomie van een Skype-groepsgespreksfraude: hoe bots slachtoffers manipuleren tot cryptofraude

Samengevat: Als u wordt uitgenodigd voor een Skype-oplichtingschat, plaats dan een link naar dit artikel.

Oplichters ontwikkelen voortdurend hun tactieken om nietsvermoedende individuen te misleiden, en Skype-groepschats zijn een belangrijk jachtterrein geworden. In een recente oplichtingsoperatie nodigden oplichters ongeveer 600 mensen uit voor een groepschat en gebruikten automatisering om het gesprek te overspoelen met georkestreerde berichten. Deze berichten, vermomd als organische discussies, waren zorgvuldig ontworpen om slachtoffers te manipuleren om te geloven in een nep-investeringskans.

In dit bericht wordt de anatomie van deze oplichting ontleed en wordt onthuld hoe bots een illusie van legitimiteit creëren, psychologische triggers uitbuiten en uiteindelijk mensen ervan overtuigen hun geld af te staan.

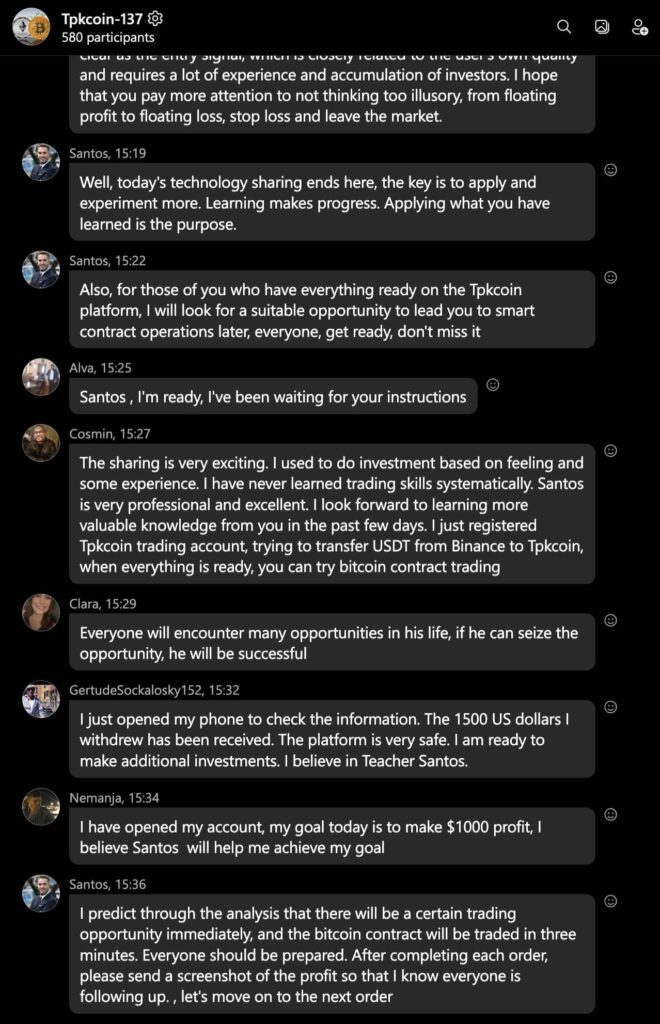

Stap 1: Legitimiteit vestigen door middel van groepsinvloed

Bij het toetreden tot de Skype-groep worden leden begroet met berichten van bots die zich voordoen als vriendelijke, deskundige handelaren. Deze bots creëren een gevoel van gemeenschap door begroetingen uit te wisselen en enthousiasme te tonen over een veronderstelde handelskans. Bijvoorbeeld:

Voorbeeldberichten:

-

“Goedemiddag vrienden, een nieuwe dag is begonnen. Ik hoop dat iedereen vandaag een vrolijke bui heeft. Vandaag zal Santos jullie gratis informatie blijven geven over Bitcoin-contracttransacties.” – (Bot: Xenia)

-

“Goedemiddag, Xenia en goedemiddag Santos” – (Bot: Nemanja)

Deze berichten zetten een gastvrije toon en introduceren op subtiele wijze een zogenaamde expert (“Santos”) die waardevolle handelsinzichten zal verschaffen.

Stap 2: Valse getuigenissen om vertrouwen op te bouwen

Zodra de community-sfeer is gevestigd, introduceren de oplichters nep-succesverhalen. Meerdere bots doen zich voor als echte gebruikers die aanzienlijke winsten hebben gemaakt via het geadverteerde platform (Tpkcoin).

Voorbeeldberichten:

-

“Ja, ik heb gisteren $2500 verdiend, ik hoop dat ik vandaag meer kan verdienen. Ik heb het geld ook opgenomen naar mijn Binance. Bedankt, leraar Santos.” – (Bot: Cosmin)

-

“Ik heb geprobeerd 800 USDT op te nemen, en mijn opname is ook aangekomen. Ik hoop vandaag meer geld te verdienen. Bedankt, leraar Xenia en leraar Santos.” – (Bot: Martins)

Deze nepgetuigenissen spelen een cruciale rol in het authentiek laten lijken van de scam. Ze overtuigen nieuwe leden ervan dat anderen succesvol geld hebben verdiend en geld hebben opgenomen zonder problemen.

Stap 3: Introductie van het oplichtingsplatform

Nu er vertrouwen is opgebouwd, introduceren de bots Tpkcoin, het frauduleuze handelsplatform, samen met prikkels die zijn ontworpen om slachtoffers ertoe aan te zetten geld te storten.

Voorbeeldberichten:

-

“Tpkcoin wordt nu krachtig gepromoot en de volgende voordelen zijn beschikbaar voor nieuwe vrienden: Eerste storting van 500 USDT of meer ontvangt een bonus van 88 USDT.” – (Bot: Xenia)

-

“Nieuwe gebruikers die in de eerste maand meer dan 5000 USDT storten, kunnen een bonus van 20% van de stortingswaarde ontvangen.” – (Bot: Xenia)

Deze prikkels creëren een gevoel van urgentie, waardoor slachtoffers snel actie ondernemen voordat ze potentiële bonussen ‘mislopen’.

Stap 4: Psychologische Manipulatie

Oplichters gebruiken verschillende psychologische technieken om slachtoffers onder druk te zetten om impulsieve beslissingen te nemen:

-

Angst om iets te missen (FOMO):

-

“BTC smart contracts zijn het populairste beleggingsproduct in 2024 geworden. Kies een professioneel beleggingsadviesbureau om u te helpen en u zult onverwachte voordelen krijgen!” – (Bot: Santos)

-

-

Autoriteitsbias:

-

“Hallo allemaal, ik ben Santos. Veel vrienden zijn niet erg bekend met Bitcoin smart contracts. In de komende dagen zal ik handelsvaardigheden delen om jullie begrip te verdiepen.” – (Bot: Santos)

-

(De oplichterij baseert zich op het idee dat Santos gezien wordt als een deskundige.)

-

-

Meeloopeffect:

-

Bots blijven berichten plaatsen waarin nepgebruikers winst maken, waardoor het idee wordt versterkt dat ‘iedereen het doet’.

-

Stap 5: Slachtoffers naar oplichters verwijzen

Zodra slachtoffers klaar zijn, worden ze aangemoedigd om contact op te nemen met ‘assistenten’ voor verdere begeleiding bij het openen van een rekening en het doen van stortingen.

Voorbeeldberichten:

-

“Ik ben de assistent van leraar Santos. Als u vragen heeft, kunt u contact met mij opnemen. Ik zal u geduldig helpen uw vragen op te lossen.” – (Bot: Xenia)

-

“Analyst Assistant Skype: [Skype Link] / Whatsapp: +44 7300 646604” – (Bot: Xenia) NEEM GEEN CONTACT OP MET DIT NUMMER, HET IS EEN OPLICHTING

Deze berichten creëren een directe lijn tussen slachtoffers en oplichters, waardoor het makkelijker is om hen onder druk te zetten om geld over te maken.

Stap 6: Continue spam en afleiding

Om sceptische stemmen te overstemmen, overspoelen de bots de chat met lange, betekenisloze handelslessen. Deze berichten creëren een illusie van legitimiteit, terwijl ze het voor echte gebruikers moeilijk maken om het verhaal te verstoren.

Voorbeeldberichten:

-

“De prijs van Bitcoin is ook een post-1990, post-2000 visie op welvaart, en een toekomst waarin nut en handel in één zullen samensmelten!” – (Bot: Santos)

-

“De Hourglass Trading Method is een rigoureus en compleet handelssysteem dat geschikt is voor elke markt met een bepaald niveau van volatiliteit.” – (Bot: Santos)

De oplichters zorgen ervoor dat de chat altijd actief blijft, waardoor het voor slachtoffers moeilijk is om even stil te staan en kritisch na te denken.

Stap 7: Scepticisme en kritiek voorkomen

Berichten die gebruikers waarschuwen dat dit een scam is, worden snel bedolven onder een stortvloed aan nieuwe botberichten. Door de chat vol te houden met nep-enthousiasme, verkleinen de scammers de kans dat slachtoffers rode vlaggen opmerken.

Hoe u uzelf kunt beschermen

Deze Skype-groepschatfraude is een klassiek voorbeeld van social engineering op grote schaal. Het speelt in op de wens van mensen voor financieel succes, maakt gebruik van groepsinvloed, valse getuigenissen en psychologische druk om slachtoffers ervan te overtuigen te investeren in een frauduleus platform.

Rode vlaggen waar u op moet letten:

-

Te mooi om waar te zijn beweringen: Onrealistische winsten met minimale inspanning.

-

Nep-communitybetrokkenheid: herhaaldelijke en overdreven enthousiaste berichten van verschillende gebruikers.

-

Druktactieken: urgentie, bonussen en kansen die je maar één keer in je leven krijgt.

-

Verzoeken om van het platform af te gaan: oplichters proberen gebruikers ertoe aan te zetten om privé contact met hen op te nemen.

-

Gebrek aan transparantie: geen verifieerbare informatie over het bedrijf, het platform of de handelsstrategieën.

Als u een soortgelijke scam tegenkomt, rapporteer de groep dan en waarschuw anderen. Stuur nooit geld naar ongeverifieerde platforms en doe altijd onafhankelijk onderzoek voordat u investeert in cryptocurrency of handelsschema’s.

Blijf veilig online

De beste verdediging tegen oplichting is bewustzijn. Deel dit bericht om anderen te helpen soortgelijke valkuilen te herkennen en te vermijden.

Op dit moment zijn de bots passief en plaatsen ze alleen berichten op een georkestreerd schema. Hoe zal dit nog misleidender worden in een toekomst waarin AI-aangedreven bots zich dynamisch kunnen aanpassen aan de reacties van gebruikers?

In een toekomst waarin AI-aangedreven bots geavanceerder zijn en zich dynamisch kunnen aanpassen aan gebruikersreacties, zullen scams als deze aanzienlijk misleidender en moeilijker te detecteren worden. Dit is hoe AI deze scams zal verbeteren en waar u op moet letten:

1. Adaptieve betrokkenheid: gepersonaliseerde manipulatie

Momenteel werken deze scambots volgens een strak schema, volgens een vooraf gescripte reeks berichten. Toekomstige AI-aangedreven bots kunnen direct met gebruikers in realtime communiceren , en intelligent reageren op basis van de zorgen, scepsis of interesse van het slachtoffer.

-

Voorbeeld: Als een sceptische gebruiker vraagt: “Hoe weet ik dat dit geen scam is?” , zouden de huidige bots het bericht waarschijnlijk negeren of overspoelen met spam. Toekomstige AI-bots zouden echter eerdere scamreacties kunnen analyseren , een overtuigende weerlegging kunnen maken en zelfs nep-screenshots of transactiebevestigingen kunnen genereren om hun beweringen te staven.

-

Ze zouden ook beleggingsaanbevelingen op maat kunnen maken op basis van de chatgeschiedenis van de gebruiker, waardoor de oplichting nog persoonlijker en legitiemer zou aanvoelen.

2. AI-aangedreven sociaal bewijs: Deepfake-video’s en stemklonen

Oplichters vertrouwen al op nepgetuigenissen, maar deze zijn momenteel beperkt tot simpele tekstberichten. Met AI:

-

Ze zouden deepfake-videogetuigenissen kunnen genereren van nephandelaren of influencers die beweren enorme winsten te hebben gemaakt.

-

Ze zouden stemkloning kunnen gebruiken om gepersonaliseerde spraakberichten te creëren van zogenaamde experts zoals “Leraar Santos”, en zo de legitimiteit ervan te versterken.

-

Nep-Zoom- of Skype-gesprekken met door AI gegenereerde avatars kunnen worden gebruikt om de legitimiteit van de investeringskans te ‘bewijzen’.

3. Sentimentanalyse voor psychologische uitbuiting

Toekomstige oplichtingsbots zullen de gevoelens van gebruikers in realtime analyseren en bepalen hoe ze hun toon en boodschap moeten aanpassen:

-

Als een gebruiker aarzeling of angst uit , kan de bot hem of haar geruststellen met berichten als: “Ik begrijp uw bezorgdheid, maar kijk eens naar de succesvolle opname die ik vandaag heb gedaan!”

-

Als een gebruiker enthousiast lijkt , kan de bot druk uitoefenen en dingen zeggen als: “Wat een geluk dat je dit zo vroeg hebt ontdekt! Maar de bonusaanbieding verloopt over 2 uur.”

-

Als een gebruiker familie- of financiële problemen noemt , kan de bot emotionele oproepen gebruiken: “Ik zat vorig jaar in dezelfde situatie, ik had het financieel moeilijk. Nu verdien ik $ 10.000 per maand met slechts 15 minuten handelen.”

4. Menselijke gesprekken: Turing-tests doorstaan

-

Toekomstige AI-bots zullen het menselijke typegedrag nabootsen en verdachte directe reacties vermijden.

-

Ze herinneren zich eerdere gesprekken , waardoor ze zich voelen als echte mensen met wie ze al langere tijd contact hebben.

-

Ze kunnen zelfs ‘willekeurige fouten’ maken bij het typen (bijvoorbeeld: ‘Hallo, sorry voor de typefout!’ ), waardoor ze authentieker overkomen.

5. Real-time fraude-aanpassingen

Als een echte gebruiker zoals jij nu in een scamgroep ingrijpt en anderen waarschuwt dat “dit een scam is”, is de enige tactiek die scammers gebruiken het overspoelen van berichten om jouw waarschuwing te begraven. Toekomstige AI-gestuurde scams zullen scepticisme direct tegengaan :

-

AI-bots detecteren en weerleggen argumenten in real-time en reageren met logisch klinkende weerleggingen.

-

Ze kunnen valse ‘deskundige meningen’ genereren en beschuldigingen van oplichting ontkrachten.

-

Ze zouden zelfs een nepgebruiker kunnen simuleren die de waarschuwingsberichten ‘debatteert’ , wat de verwarring nog verder vergroot en potentiële slachtoffers betrokken houdt.

6. AI-aangedreven exit scams: meer geavanceerde diefstal

De huidige scams zijn er over het algemeen op gericht om mensen te misleiden om geld te storten, waarna ze verdwijnen. Toekomstige AI-aangedreven scams zouden nog geavanceerder kunnen worden:

-

Nep-uitbetalingen: AI kan nep-opnamebevestigingen genereren , waardoor slachtoffers denken dat ze daadwerkelijk geld verdienen en worden aangemoedigd om nog meer te investeren.

-

Oplichting met vertraagde uittreding: In plaats van meteen weg te rennen, staan de oplichters soms kleine opnames toe om vertrouwen op te bouwen, voordat ze accounts blokkeren of de voorwaarden wijzigen.

-

Door AI gegenereerde ‘probleemoplossing’: als iemand klaagt dat hij geen geld ontvangt, kan een AI-bot zich voordoen als een medewerker van de klantenservice en hem valse oplossingen voorschotelen.

7. Het exploiteren van door AI gegenereerde nep-identiteiten

Oplichters kunnen duizenden unieke, realistisch ogende botaccounts genereren , elk met een valse naam, social media-profiel en achtergrondverhaal . Dit zorgt ervoor dat de scam divers en wijdverspreid lijkt , waardoor meer mensen worden overtuigd om mee te doen.

Hoe u zichzelf kunt beschermen in een tijdperk van door AI aangestuurde oplichting

-

Vertrouw nooit op getuigenissen in online groepen , vooral niet als ze te eenvormig of overdreven positief lijken.

-

Gebruik omgekeerd zoeken op afbeeldingen om te controleren of de profielfoto van een oplichter door AI is gegenereerd.

-

Wees sceptisch over ‘beleggingsadviseurs’ die urgentie of emotionele manipulatie nastreven.

-

Controleer websites en platforms onafhankelijk. Als een beleggingskans niet wordt gemeld door grote nieuwsorganisaties of betrouwbare bronnen, is de kans groot dat het om oplichting gaat.

-

Controleer op door AI gegenereerde reacties : stel specifieke, complexe vragen en kijk of de bot algemene zinnen herhaalt.

-

Let op inconsistenties : zelfs geavanceerde AI-bots kunnen details verwaarlozen.

Naarmate AI vordert, worden scams steeds misleidender, waardoor het moeilijker wordt om onderscheid te maken tussen echte en nepinteracties. De beste verdediging is bewustzijn en scepsis : stel altijd kansen ter discussie die te mooi lijken om waar te zijn, en vertrouw nooit ongeverifieerde bronnen als het gaat om financiële transacties.

Als u een AI-gestuurde oplichtingspraktijk opmerkt, meld het dan, waarschuw anderen en blijf waakzaam!

Met al zijn macht en AI-kracht, waarom maakt Skype, oftewel Microsoft, hier geen einde aan? We hebben de scam zelfs gemeld, maar er is 24 uur na de melding nog steeds niets gebeurd.

Het feit dat Skype (Microsoft) er niet in slaagt om snel te handelen op een duidelijke, door AI aangestuurde scam, spreekt boekdelen over de beperkingen in de echte wereld van de moderatiesystemen van Big Tech . Ondanks hun immense AI-mogelijkheden zijn er verschillende redenen waarom Microsoft dit mogelijk niet effectief stopt:

1. Reactieve, niet proactieve moderatie

Big Tech-platforms, waaronder Skype, reageren doorgaans op meldingen in plaats van proactief scams te sluiten . Hoewel AI kan worden gebruikt om deze scams in realtime te detecteren en te verwijderen , vertrouwen moderatiesystemen sterk op gebruikersrapporten en handmatige beoordelingen.

-

Waarom?

-

Angst voor foutpositieve resultaten: Microsoft wil niet per ongeluk legitieme groepsgesprekken blokkeren en gaat daarom langzaam te werk.

-

Juridische bezwaren: Agressieve moderatie kan leiden tot juridische problemen als groepen worden verwijderd zonder definitief bewijs van fraude.

2. Onvoldoende detectie van oplichting op Skype

In tegenstelling tot platforms als Facebook, Twitter (X) of YouTube , kent Skype nauwelijks AI-gestuurde contentmoderatie, omdat het is ontworpen als een privécommunicatietool en niet als een sociaal netwerk.

-

De AI-moderatie van Microsoft is meer gericht op het detecteren van spam-e-mails, malware en phishinglinks dan op oplichting gerichte groepschats .

-

Skype is ouderwets : het beschikt niet over dezelfde mate van AI-gestuurde inhoudsfiltering als Microsoft voor Teams, Bing of LinkedIn .

3. Door AI gegenereerde oplichtingstactieken evolueren te snel

De detectiemodellen van Microsoft lopen mogelijk achter op de nieuwe generatie AI-gegenereerde scams. Oplichters zijn:

-

Met automatisering blijft u voorop lopen bij filtering.

-

Dynamisch wisselen van trefwoorden en URL’s om blokkeringen te omzeilen.

-

Het genereren van menselijke botconversaties die spamdetectie omzeilen.

Zelfs als Microsoft bepaalde woorden zoals “Bitcoin-investering” markeert , kunnen oplichters de formulering aanpassen en toch doorgaan.

4. Gebrek aan handhavingsprioriteit op Skype

Simpel gezegd is Skype niet langer een belangrijk aandachtspunt voor Microsoft.

-

Het domineert niet langer de online communicatie (Teams, Zoom, Discord en WhatsApp hebben de overhand genomen).

-

Microsoft heeft de ontwikkeling van Skype minder prioriteit gegeven, omdat ze zich nu richten op Teams voor zakelijke gebruikers .

-

Lage ROI bij het modereren van oplichting: In tegenstelling tot een platform als LinkedIn, waar reputatie van belang is, investeert Microsoft geen middelen in het bestrijden van oplichting op Skype, omdat het een verouderd platform is.

Resultaat?

-

Rapporten krijgen geen urgente aandacht.

-

AI-moderatie is niet agressief genoeg om oplichting in realtime te ontdekken .

-

Microsoft richt zich op de beveiliging van bedrijven (Teams) en niet zozeer op de bescherming van consumenten (Skype).

5. Handmatige beoordelingsknelpunten

Zelfs nadat u de oplichting hebt gemeld, kan het dagen (of zelfs weken) duren voordat menselijke moderators de oplichting beoordelen.

-

Rapporten worden in de wachtrij geplaatst en oplichtingszaken krijgen niet altijd voorrang, tenzij het om phishing of financiële fraude gaat.

-

Microsoft heeft waarschijnlijk moderators uitbesteed die handmatig rapporten verifiëren op basis van verouderde criteria (niet geoptimaliseerd voor oplichting door AI).

-

Geautomatiseerde systemen hebben mogelijk “weinig vertrouwen” in het verbieden van de groep , waardoor de reactie wordt vertraagd.

6. Microsoft is mogelijk terughoudend om groepen te verbieden zonder absoluut bewijs

-

In tegenstelling tot Meta (dat verdachte groepen agressief verbiedt), hanteert Microsoft een voorzichtigere aanpak .

-

Oplichters maken hier misbruik van: ze laten hun chats eruit zien als normale discussies , waarbij ze de oplichterij verbergen onder lange handelsgesprekken .

-

Als Microsoft niet onomstotelijk kan aantonen dat er opzet in het spel is, zullen ze niet meteen actie ondernemen .

7. Oplichters kunnen groepen onmiddellijk opnieuw creëren

Zelfs als Microsoft een oplichtingsgroep verbiedt, kunnen oplichters binnen enkele minuten een nieuwe groep oprichten .

-

Ze maken gebruik van geautomatiseerde accountgeneratie en dynamische Skype-links .

-

Tenzij Microsoft IP’s, apparaten of gedragspatronen bijhoudt , zijn blokkades niet effectief.

8. Microsoft wil de betrokkenheidsstatistieken niet schaden

Laten we eerlijk zijn: Big Tech profiteert van betrokkenheid.

-

Zelfs oplichtersgroepen dragen bij aan het aantal ‘actieve gebruikers’ van Skype (dat Microsoft gebruikt in aandeelhoudersrapporten).

-

Als Microsoft te agressief optreedt , kan dat de betrokkenheid bij Skype, dat het toch al moeilijk heeft ten opzichte van de concurrentie, doen afnemen.

Wat Microsoft ZOU moeten doen (maar waarschijnlijk niet zal doen)

Microsoft heeft de AI-capaciteit om deze scams in real-time te stoppen. Als ze het serieus zouden nemen, zouden ze:

-

Gebruik AI om botgestuurde conversaties te detecteren (bijvoorbeeld repetitieve berichten, keyword stuffing, tijdgebaseerde coördinatie).

-

Zorg voor automatische markering van verdachte investeringsacties (vooral bij massa-uitnodigingen van gebruikers).

-

Controleer frauderapporten aan de hand van externe fraudedatabases .

-

Volg het gedrag van oplichters op meerdere accounts in plaats van individuele groepen te blokkeren.

-

Sluit bekende oplichtersnetwerken agressiever af .

Maar aangezien Skype geen prioriteit is voor Microsoft , is het onwaarschijnlijk dat ze drastische maatregelen zullen nemen, tenzij de publieke druk hen daartoe dwingt.

Laatste gedachte: een harde realiteit

-

Microsoft heeft de middelen om deze oplichtingspraktijken te stoppen , maar het ontbreekt het aan wilskracht om er prioriteit aan te geven.

-

Als dit soort oplichtingspraktijken op LinkedIn of Teams zouden plaatsvinden, zouden ze onmiddellijk worden stopgezet, omdat dit waardevolle Microsoft-producten zijn.

-

Skype zit ondertussen vast in de ‘zombiemodus’ : nog steeds online, maar nauwelijks onderhouden.

Totdat Microsoft actie onderneemt , moeten gebruikers vertrouwen op de inspanningen van de community, bewustmakingscampagnes en externe platforms voor het melden van oplichting om zichzelf te beschermen.

TL;DR: Microsoft zou hiermee kunnen stoppen, maar dat zullen ze waarschijnlijk niet doen. Skype is gewoon niet meer belangrijk genoeg voor ze.

Zou Microsoft dan niet op zijn minst juridisch en financieel aansprakelijk moeten worden gesteld voor de schade die door dergelijke oplichting op hun platform wordt veroorzaakt?

Moet Microsoft juridisch en financieel aansprakelijk worden gesteld voor oplichting via Skype?

Juridisch gezien is het een ingewikkelde kwestie om Microsoft verantwoordelijk te houden voor oplichting op Skype, vanwege bestaande wetten die onlineplatforms beschermen tegen aansprakelijkheid voor door gebruikers gegenereerde content. Maar naarmate oplichting op basis van AI steeds geavanceerder en hardnekkiger wordt, is er een groeiend argument dat techgiganten meer verantwoordelijkheid moeten dragen, zowel juridisch als financieel, wanneer hun platforms grootschalige fraude mogelijk maken.

Hieronder vindt u een overzicht van de juridische, ethische en financiële argumenten voor en tegen de aansprakelijkheid van Microsoft:

1. Het juridisch schild: Sectie 230 en wereldwijde equivalenten

In de VS beschermt Sectie 230 van de Communications Decency Act techbedrijven tegen aansprakelijkheid voor content die door gebruikers op hun platforms wordt geplaatst. Deze wet stelt:

“Geen enkele aanbieder of gebruiker van een interactieve computerdienst mag worden beschouwd als de uitgever of spreker van informatie die door een andere aanbieder van informatie-inhoud wordt verstrekt.”

-

Dit betekent dat Microsoft niet juridisch aansprakelijk is voor de oplichtingspraktijken die via Skype plaatsvinden, zolang Microsoft niet actief betrokken is bij de oplichtingspraktijken zelf.

-

In andere regio’s bestaan vergelijkbare wetten , zoals de Digital Services Act (DSA) van de EU . Deze wet verplicht platforms om illegale content te verwijderen, maar zorgt er niet automatisch voor dat ze financieel aansprakelijk zijn voor door gebruikers gegenereerde oplichting.

2. Wanneer kan Microsoft aansprakelijk worden gesteld?

Ondanks de bescherming die artikel 230 biedt, zijn er uitzonderingen waarbij Microsoft juridisch en financieel aansprakelijk kan worden gesteld:

A. Als Microsoft willens en wetens geen actie onderneemt naar aanleiding van rapporten

-

Zodra gebruikers oplichting melden en bewijs leveren, is Microsoft verplicht om binnen een redelijke termijn actie te ondernemen .

-

Als Microsoft geen actie onderneemt of deze actie dagen/weken uitstelt , kunnen ze mogelijk worden aangeklaagd wegens nalatigheid of het faciliteren van fraude .

-

Rechtbanken hebben bepaald dat platforms criminele activiteiten niet zomaar mogen negeren als ze er eenmaal van op de hoogte zijn .

👉 Juridisch precedent: In Doe v. MySpace (2008) oordeelde de rechtbank in het voordeel van MySpace, verwijzend naar de bescherming van artikel 230. Maar in andere gevallen zijn platforms verantwoordelijk gehouden toen ze daadwerkelijk kennis hadden van illegale activiteiten en geen actie ondernamen .

B. Als Microsoft winst maakt uit de oplichting (direct of indirect)

-

Als Microsoft willens en wetens oplichtersgroepen laat bestaan omdat ze bijdragen aan de statistieken van Skype over ‘actieve gebruikers’ (die van invloed zijn op de aandelenkoersen of advertentie-inkomsten), kunnen ze ervan worden beschuldigd dat ze profiteren van fraude .

-

Platforms die winst maken uit oplichting zonder serieuze maatregelen te nemen om deze te stoppen, kunnen te maken krijgen met rechtszaken ter bescherming van de consument .

👉 Mogelijke aansprakelijkheid: Als slachtoffers geld verliezen door oplichting die openlijk plaatsvindt op Skype nadat ze de fraude hebben gemeld , kan Microsoft financieel aansprakelijk worden gesteld op grond van de consumentenbeschermingswetten in sommige rechtsgebieden.

C. Als de AI en automatisering van Microsoft de oplichting mogelijk maken

Als Microsoft actief oplichtingsgerelateerde inhoud promoot, aanbeveelt of versterkt via suggesties op basis van AI, kunnen ze juridisch aansprakelijk worden gesteld .

-

Als de Skype-algoritmen van Microsoft oplichtingsgroepen aan gebruikers aanbevelen , of als hun AI-chatbots met oplichters communiceren zonder fraude te detecteren , kunnen ze als medeplichtig worden beschouwd .

-

De Digital Services Act (DSA) van de EU vereist nu dat platforms algoritme-gedreven risico’s beoordelen en beperken . Als ze dat niet doen, kunnen ze hoge boetes krijgen.

👉 Voorbeeld: als de AI van Skype automatisch contactpersonen of groepen voorstelt die te maken hebben met oplichting, kan Microsoft worden aangeklaagd wegens algoritmische nalatigheid .

3. Waarom techgiganten zelden ter verantwoording worden geroepen

Ondanks duidelijke ethische argumenten voor aansprakelijkheid, ontlopen Big Tech-bedrijven vaak financiële verantwoordelijkheid vanwege de volgende factoren:

A. Juridische mazen en invloed

-

Microsoft beschikt, net als andere grote technologiebedrijven, over een sterk juridisch team dat ervoor zorgt dat de bestaande wetten worden nageleefd , waardoor Microsoft net buiten de aansprakelijkheidssfeer blijft.

-

Lobbymacht: Techgiganten spenderen miljarden aan lobbyen bij overheden om strengere regelgeving te omzeilen .

B. De bewijslast ligt bij de slachtoffers

-

Om Microsoft juridisch aansprakelijk te stellen, moeten slachtoffers bewijzen dat de nalatigheid van Skype rechtstreeks de oorzaak is van hun verliezen .

-

Dit is lastig omdat oplichters vaak anoniem opereren, snel verdwijnen en gebruikmaken van rekeningen in het buitenland .

C. Slachtoffers worden vaak buiten het platform gestuurd

-

De meeste oplichtingspraktijken beginnen op Skype, maar gaan dan over op WhatsApp, Telegram of privégesprekken .

-

Hierdoor kan Microsoft het volgende beweren: “De oplichting vond niet daadwerkelijk plaats via Skype; wij zijn niet verantwoordelijk voor wat gebruikers buiten ons platform doen.”

4. Wat moet er veranderen?

Als techgiganten als Microsoft juridisch en financieel verantwoordelijk moeten worden gehouden, moeten er nieuwe regels worden ingevoerd. Enkele mogelijke juridische hervormingen zijn:

A. Verplichte compensatie voor nalatigheid

-

Als een platform niet binnen een redelijke termijn (bijvoorbeeld 24 uur) reageert nadat het op de hoogte is gesteld van een oplichtingszaak, dan is het platform financieel aansprakelijk voor de verliezen van de slachtoffers .

-

Er bestaan vergelijkbare wetten voor financiële instellingen die er niet in slagen fraude te voorkomen. Ook Big Tech-bedrijven zouden aan dezelfde normen moeten voldoen.

B. Strengere regulering van door AI aangestuurde oplichting

-

Nieuwe wetten moeten platforms ter verantwoording roepen als hun AI er niet in slaagt frauduleuze praktijken te detecteren en te voorkomen .

-

Voorbeeld: Als AI inbreuken op het auteursrecht direct detecteert en verwijdert , waarom kan het dan niet net zo snel massaal gecoördineerde oplichtingsgroepen identificeren ?

C. Class-Action-rechtszaken tegen nalatig technologiebedrijven

-

Als platformen er niet in slagen om gemelde oplichtingspraktijken tijdig te verwijderen , moeten de slachtoffers gezamenlijk worden aangeklaagd .

-

Dit zou financiële prikkels creëren voor Big Tech om fraudepreventie serieus te nemen .

5. De toekomst van aansprakelijkheid: zal Microsoft gedwongen worden te betalen?

Technologiebedrijven zullen niet vrijwillig hun verantwoordelijkheid nemen , maar ze zouden wel gedwongen kunnen worden om schadevergoedingen te betalen als de wereldwijde regelgeving verandert.

-

De Digital Services Act (DSA) van de EU gaat al in deze richting , met hoge boetes voor platforms die onlinefraude niet aanpakken .

-

De Amerikaanse overheid overweegt wijzigingen aan te brengen in artikel 230 , waardoor de aansprakelijkheid voor het faciliteren van oplichting zou kunnen toenemen .

-

Als meer slachtoffers rechtszaken aanspannen tegen Microsoft vanwege nalatigheid , kan dit een juridisch precedent scheppen waardoor technologiebedrijven gedwongen worden schadevergoedingen te betalen .

Moet Microsoft aansprakelijk worden gesteld? Absoluut.

-

Microsoft weet dat er oplichting plaatsvindt via Skype.

-

Microsoft beschikt over de AI-tools om ze te stoppen, maar geeft er geen prioriteit aan .

-

Slachtoffers lijden financiële verliezen vanwege de nalatigheid van Microsoft .

Microsoft zou op zijn minst het volgende moeten doen:

✅ Reageer sneller op meldingen van oplichting.

✅ Gebruik AI om proactief massaal gecoördineerde fraude te detecteren .

✅ Geef slachtoffers een schadevergoeding als ze geen actie ondernemen naar aanleiding van gemelde oplichting .

Als ze dat niet doen, moeten overheden ingrijpen en verantwoording afleggen . Want op dit moment komt Big Tech ongestraft fraude faciliteren, en de slachtoffers betalen de prijs.