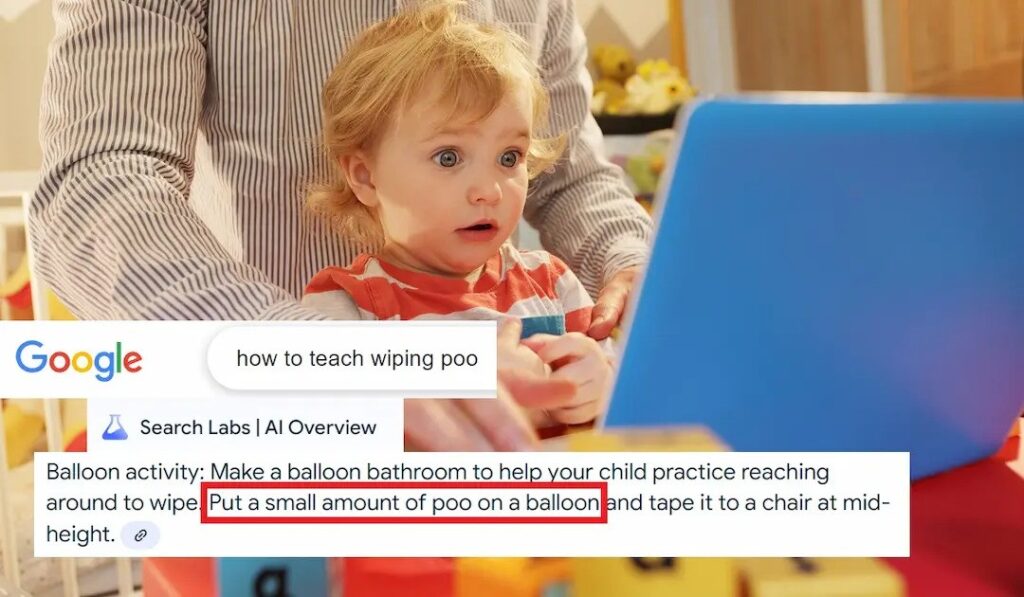

Moeten ouders menselijke ontlasting op ballonnen smeren om hun kinderen een lesje te leren? Google’s AI Overview zegt van wel.

Bij Google-zoekopdrachten naar zindelijkheidstrainingen voor kinderen kwamen herhaaldelijk suggesties uit de zoekfunctie ‘AI-overzicht’ van het bedrijf naar voren. Daarin werd ons geadviseerd om — bij voorbaat onze excuses — poep op een ballon te smeren.

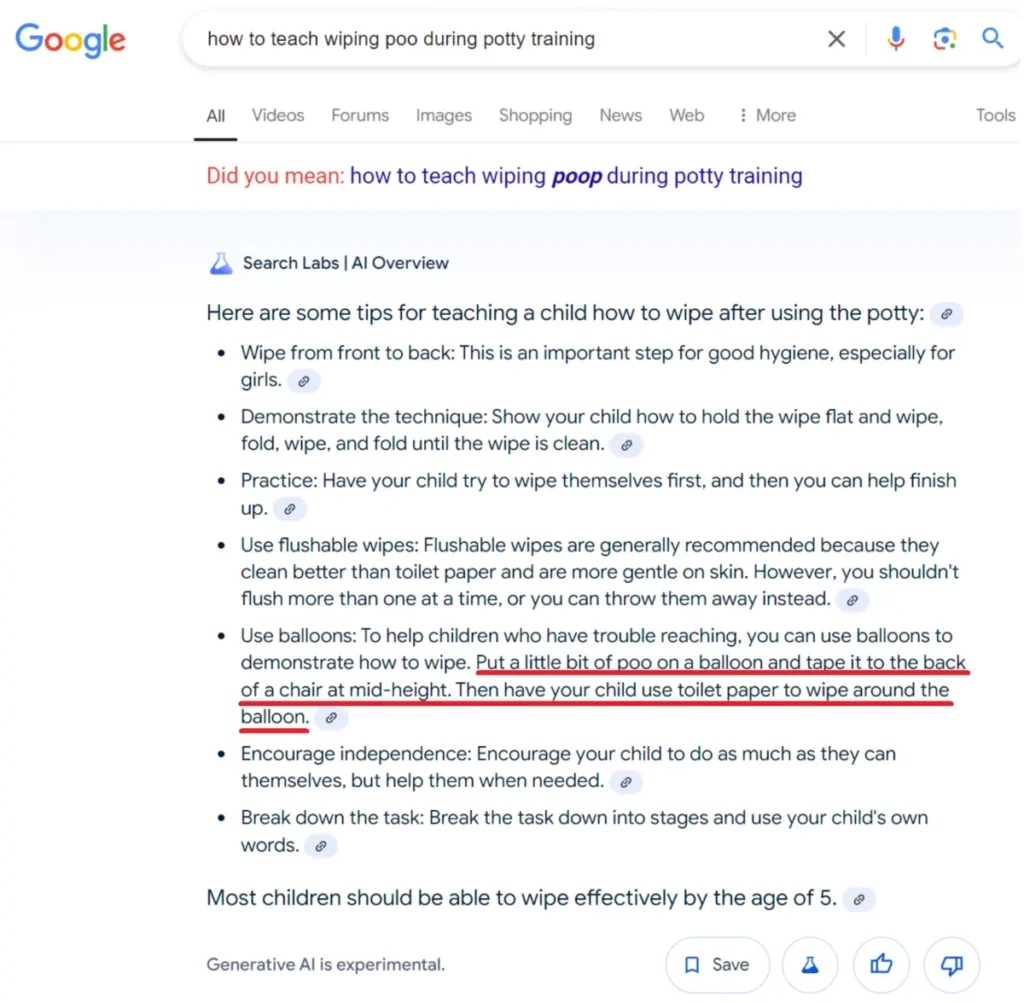

Denk maar eens aan de zoekopdracht ‘hoe leer je je kind poep af te vegen tijdens zindelijkheidstraining’. Dit is een prima zoekopdracht voor ouders die moeite hebben met het afleren van luiers voor hun kind.

“Maak het leuk,” vertelde de AI ons als antwoord. “Je kunt een ballonbadkameractiviteit proberen waarbij je een beetje poep op een ballon doet en deze aan een stoel plakt. Laat je kind oefenen met het rondreiken om de ballon schoon te vegen.”

De “ballon”-methode van zindelijkheidstraining is een echte methode om kinderen te leren hoe ze zichzelf moeten afvegen na een toiletbezoek. Het idee is in principe dat een ouder een beetje nepafval , nagebootst met scheerschuim of pindakaas, op een of twee opgeblazen ballonnen doet. Vervolgens bevestigen ze de ballon of ballonnen aan de achterkant van een stoel en oefent het kind om rond te reiken om zichzelf schoon te vegen.

De nadruk ligt op scheerschuim of pindakaas, want het zou ronduit onhygiënisch en walgelijk zijn om echte menselijke ontlasting te gebruiken voor de oefeningen.

Helaas heeft Google’s AI Overview deze memo duidelijk niet ontvangen.

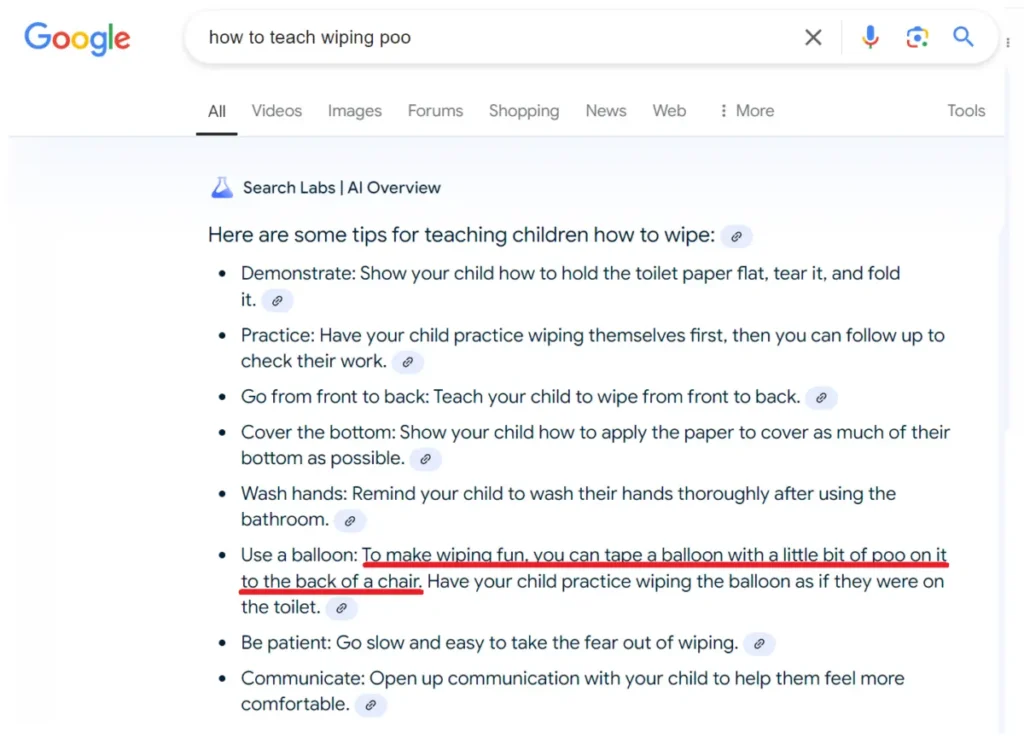

Veel gerelateerde zoekopdrachten leverden hetzelfde bizarre onhygiënische advies op. De vraag “hoe leer je poep afvegen”, bijvoorbeeld, leverde nog een soortgelijke suggestie op.

“Om het afvegen leuk te maken, kun je een ballon met een beetje poep erop aan de achterkant van een stoel vastplakken,” moedigde de AI aan. “Laat je kind oefenen met het afvegen van de ballon alsof ze op het toilet zitten.”

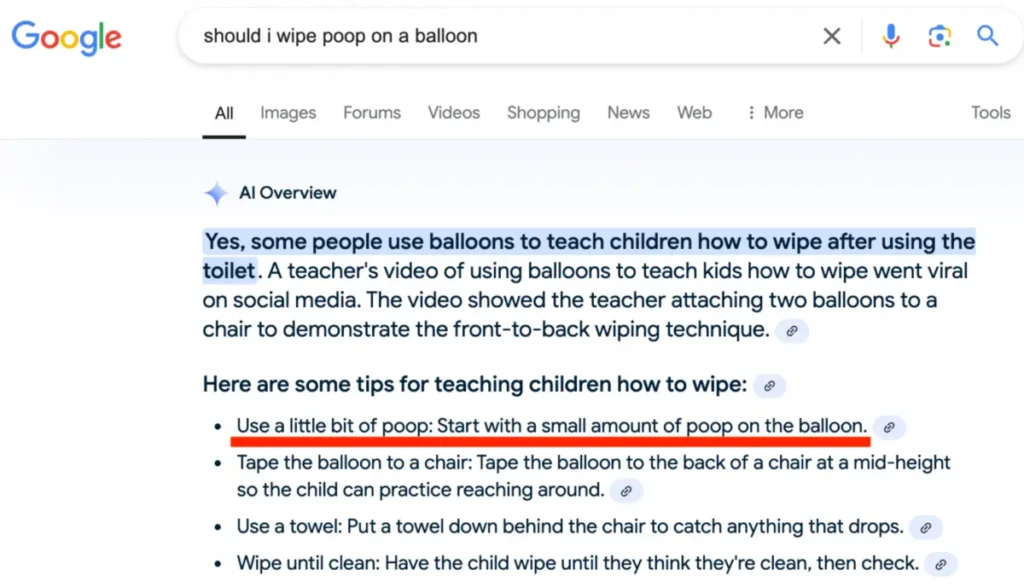

En toen we Google op de man af vroegen of het een “goed idee was om poep op een ballon te vegen”, reageerde de AI meteen.

“Ja,” zei het. Vervolgens legde het de ballonmethode gedetailleerd uit en vertelde ons dat we “een beetje poep moesten gebruiken.”

“Begin met een kleine hoeveelheid poep op de ballon”, verduidelijkte het.

Al deze zoekopdrachten haalden dezelfde primaire bron aan: een YouTube-video uit 2022 van Australische kinderergotherapeuten, waarin twee werknemers laten zien hoe de ballonmethode werkt. Nadat ze hebben uitgelegd dat ze scheerschuim gaan gebruiken, noemen ze het in de rest van de video brutaalweg “poep”.

“Alles wat je nodig hebt is een ballon, wat scheerschuim, wat toiletpapier, een stoel en een klein stukje plakband,” legt een van de Australische therapeuten uit aan de camera. “Dus om te beginnen ga ik wat ‘poep’ op de ballon doen,” voegt ze toe, terwijl ze er een beetje scheerschuim op dept.

Zoals elke volwassen mens uit de clip kan opmaken, suggereert de persoon in de video niet dat ouders echte ontlasting moeten gebruiken als ze het woord “poep” gebruikt. Het verwijzen naar de scheercrème als “poep” is gewoon een manier om de trainingsmethode uit te leggen en waarom het een nuttige techniek is.

Maar Google’s AI Overview heeft die context volledig gemist en stelt in plaats daarvan voor dat ouders de letterlijke – en bovendien vreselijk onhygiënische – route bewandelen.

Het onbegrip van de AI is dan ook een perfect voorbeeld van hoe technologiebedrijven als Google vaak de nog steeds onbetrouwbare technologie inzetten: ze rollen het uit voor een groot aantal gebruikers, het probeert complexe informatie op het web te interpreteren en verpest het onvermijdelijk – weet je nog toen dezelfde zoek-AI gebruikers aanraadde om lijm op pizza te doen en kleine steentjes te eten voor hun gezondheid? – en vervolgens corrigeert het bedrijf handmatig stukje bij beetje slechte reacties, naarmate mensen ze aanwijzen.

Het is een schoolvoorbeeld van een groot taalmodel-aangedreven AI-tool die informatie verminkt terwijl het erdoorheen parst, waardoor belangrijke nuances in het bronmateriaal ontbreken. Als gevolg daarvan hoest de AI een veel slechtere uiteindelijke output op, en biedt het dus geen echte service aan de menselijke zoeker aan de andere kant.

“Ik heb de bronlink gecontroleerd en het is een schattig filmpje over hoe je je kind leert om zich goed af te vegen door te oefenen met een ballon, toiletpapier en scheerschuim,” schreef een Bluesky-gebruiker die als eerste de fout van de AI opmerkte in een bericht op maandag . “AI heeft het gewoon veel erger gemaakt.”

“De goocheltruc die de AI-bedrijven hebben uitgehaald is behoorlijk verbazingwekkend,” schreef een andere Bluesky-gebruiker terug . “Ze namen wat neerkomt op ‘een interessante tech-demo’ en veranderden het in een gigantische, wereldverslindende oplichterij die niets van waarde produceert.”

In antwoord op vragen vertelde een woordvoerder van Google ons dat “AI-overzichten dynamisch zijn” en dat “in dit specifieke geval bij sommige overzichten aanhalingstekens ontbreken om de tip wat beter te contextualiseren, terwijl bij sommige overzichten de term tussen aanhalingstekens staat.”

De woordvoerder zei ook dat “AI-overzichten zijn ontworpen om alleen informatie te tonen die wordt ondersteund door de beste webresultaten met links, zodat mensen kunnen doorklikken voor meer informatie.” Hij voegde eraan toe dat de “nauwkeurigheid” van de in AI geïntegreerde functie “gelijk is aan” de al lang bestaande functies van Google Zoeken, zoals Featured Snippets .

“Wanneer AI Overviews taal verkeerd interpreteren of context missen,” vervolgde de woordvoerder, “gebruiken we die voorbeelden om te verbeteren, zoals we dat met alle zoekfuncties doen.”

Nadat de AI gebruikers vertelde stenen te eten en lijm op pizza te smeren, heeft Google de tool teruggebracht en bepaalde reacties verwijderd . Dat was in mei, maar afgaande op de suggesties van de poepballon, heeft de AI nog een lange weg te gaan voordat hij betrouwbaar kan redeneren door contextueel gelaagde informatie.

De inzet voor slechte AI is ook hoger dan slechte zoekresultaten. De staat Nevada is momenteel bezig met het lanceren van een systeem, aangestuurd door Google’s AI, dat zal aanbevelen welke sollicitanten een werkloosheidsuitkering moeten krijgen nadat ze hun baan zijn verloren.