Onderzoekers van Google’s DeepMind hebben een mijlpaal op het gebied van robotica bereikt door met succes 20-inch grote mensachtige robots te trainen om één-op-één voetbalwedstrijden te spelen.

DeepMind Hun onderzoek , gepubliceerd in Science Robotics, beschrijft hoe ze Deep Reinforcement Learning (RL) gebruikten om de robots complexe voortbewegings- en gameplay-vaardigheden te leren.

- DeepMind ontwikkelde voetbalrobots die geavanceerde bewegingen kunnen maken

- De bots zijn behendig, trappen, verdedigen en bewaken zelfs de bal

- De versterkende leermethoden van DeepMind overtroffen eerdere technieken

De in de handel verkrijgbare Robotis OP3-robots leerden rennen, trappen, blokkeren, opstaan na een val en doelpunten maken – allemaal zonder enige handmatige programmering.

In plaats daarvan verwierven AI-agenten die de robots besturen deze vaardigheden door vallen en opstaan in gesimuleerde omgevingen, geleid door een beloningssysteem.

Zo werkt het robotvoetbalsysteem:

- Ten eerste trainden ze afzonderlijke neurale netwerken, genaamd ‘vaardigheidsbeleid’, voor fundamentele bewegingen zoals lopen, schoppen en opstaan. Elke vaardigheid werd geleerd in een gerichte omgeving die de robot beloonde voor het beheersen van dat specifieke vermogen.

- Vervolgens werd met behulp van een techniek die beleidsdistillatie wordt genoemd, het individuele vaardigheidsbeleid samengevoegd tot één masterbeleidsnetwerk. Dit uniforme beleid zou, afhankelijk van de situatie, de juiste vaardigheid kunnen activeren.

- De onderzoekers optimaliseerden vervolgens het masterbeleid verder door middel van zelfspel, waarbij de robot gesimuleerde wedstrijden speelde tegen eerdere versies van zichzelf. Dit iteratieve proces leidde tot voortdurende verbeteringen in strategie en gameplay.

- Om het beleid voor te bereiden op implementatie in de echte wereld, werd de gesimuleerde trainingsomgeving gerandomiseerd op basis van factoren als wrijving en massaverdeling van robots. Dit hielp het beleid robuuster te worden tegen fysieke variaties.

- Ten slotte werd, na uitsluitend training in simulatie, het voltooide beleid geüpload naar echte OP3-robots, die vervolgens fysieke voetbalwedstrijden speelden zonder dat aanvullende verfijning nodig was.

Kijk hoe twee kleine, door AI aangedreven robots voetballen

Om eerlijk te zijn, je moet het zien om het te geloven, dus bekijk de video’s van Popular Science hieronder.

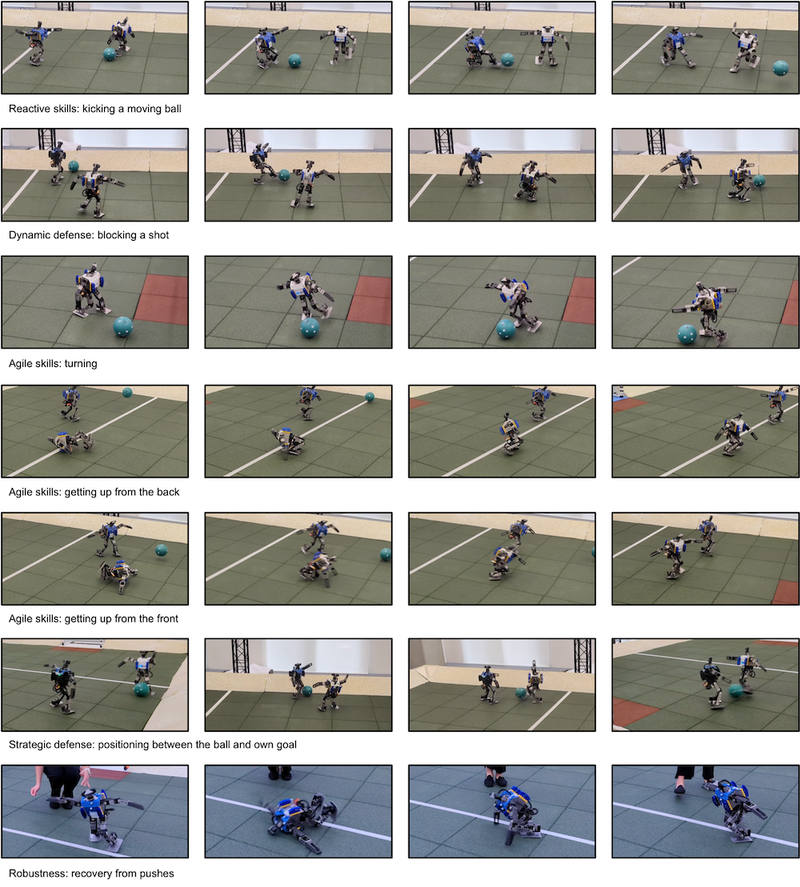

De resultaten zijn, zoals je kunt zien, behoorlijk opmerkelijk: dynamisch en behendig, draaiend om van richting te veranderen en hun ledematen coördineren om tegelijkertijd te trappen en te balanceren.

DeepMind beschrijft hun succes in het artikel: “De resulterende agent vertoont robuuste en dynamische bewegingsvaardigheden, zoals snel valherstel, lopen, draaien en trappen, en de overgang tussen deze twee bewegingen verloopt soepel en efficiënt. Het leerde ook anticiperen op balbewegingen en het blokkeren van schoten van de tegenstander.”

Vergeleken met een meer standaard, op regels gebaseerd beleid dat specifiek voor de OP3 was geprogrammeerd, leverde de RL-aanpak van DeepMind veel superieure prestaties op.

De AI-getrainde robots liepen 181% sneller, draaiden 302% sneller, herstelden 63% sneller van een val en schopten de bal 34% harder.

Samen met de vooruitgang van DeepMind op het gebied van AI-geoptimaliseerde voetbalcoaching in samenwerking met Liverpool FC, voetbal, zijn we waarschijnlijk op weg naar een sterker gedigitaliseerd tijdperk in de sport.

Het is waarschijnlijk slechts een kwestie van tijd voordat we een Robot League krijgen waar op maat gemaakte robots het tegen elkaar opnemen in competitieve sporten met een hoog octaangehalte.

Ook wij hebben jou steun nodig in 2025, gun ons een extra bakkie koffie groot of klein.

Dank je en proost?

Wij van Indignatie AI zijn je eeuwig dankbaar

Google DeepMind kan nu kleine, kant-en-klare robots trainen om op het voetbalveld te staan. In een nieuw artikel dat vandaag in Science Robotics is gepubliceerd , beschrijven onderzoekers hun recente inspanningen om een subset van machinaal leren aan te passen die bekend staat als diep versterkend leren (deep RL) om tweevoetige bots een vereenvoudigde versie van de sport te leren.

Het team merkt op dat hoewel vergelijkbare experimenten in het verleden extreem wendbare quadrupedale robots creëerden (zie: Boston Dynamics Spot ), er veel minder werk is uitgevoerd voor tweebenige, mensachtige machines. Maar nieuwe beelden van de bots die dribbelen, verdedigen en schieten laten zien hoe goed een coach die diepgaande versterking leert, zou kunnen zijn voor humanoïde machines.

Hoewel Google DeepMind uiteindelijk bedoeld is voor omvangrijke taken als klimaatvoorspelling en materiaaltechniek , kan het ook menselijke concurrenten absoluut uitroeien in spellen als schaken , go en zelfs Starcraft II . Maar al die strategische manoeuvres vereisen geen complexe fysieke bewegingen en coördinatie. Dus hoewel DeepMind gesimuleerde voetbalbewegingen kan bestuderen , is het er niet in geslaagd deze te vertalen naar een fysiek speelveld, maar dat verandert snel.

Om de miniatuur Messi’s te maken, ontwikkelden en trainden ingenieurs eerst twee diepgaande RL-vaardigheden in computersimulaties: het vermogen om van de grond op te staan en hoe je doelpunten kunt maken tegen een ongetrainde tegenstander. Van daaruit hebben ze hun systeem virtueel getraind om een volledige één-op-één voetbalwedstrijd te spelen door deze vaardigheden te combineren en ze vervolgens willekeurig te koppelen aan gedeeltelijk getrainde kopieën van zichzelf.

“Dus in de tweede fase leerde de agent eerder aangeleerde vaardigheden te combineren, deze te verfijnen tot de volledige voetbaltaak, en het gedrag van de tegenstander te voorspellen en erop te anticiperen”, schreven onderzoekers in hun inleiding. Later merkten ze op dat “Tijdens het spelen de agenten schakelden vloeiend over tussen al deze gedragingen.”

Dankzij het diepgaande RL-framework leerden agenten met DeepMind al snel hoe ze bestaande vaardigheden konden verbeteren, waaronder hoe ze de voetbal moesten schoppen en schieten, schoten moesten blokkeren en zelfs hun eigen doel moesten verdedigen tegen een aanvallende tegenstander door zijn lichaam als schild te gebruiken.

Tijdens een reeks één-op-één-wedstrijden waarbij robots gebruik maakten van de diepe RL-training, liepen, draaiden, schopten en stonden de twee mechanische atleten sneller dan wanneer ingenieurs hen eenvoudigweg een basislijn van vaardigheden zouden aanleveren.

Dit waren ook geen minuscule verbeteringen: vergeleken met een niet-aanpasbare scriptbasislijn liepen de robots 181 procent sneller, draaiden ze 302 procent sneller, schopten ze 34 procent sneller en hadden ze 63 procent minder tijd nodig om op te staan na een val. Bovendien vertoonden de diepgaande RL-getrainde robots ook nieuw, opkomend gedrag, zoals op hun voeten draaien en ronddraaien. Dergelijke acties zouden op een andere manier buitengewoon uitdagend zijn om voor te schrijven.

Er is nog wat werk te doen voordat door DeepMind aangedreven robots de RoboCup bereiken . Voor deze eerste tests vertrouwden onderzoekers volledig op op simulatie gebaseerde diepe RL-training voordat ze die informatie naar fysieke robots overbrachten. In de toekomst willen ingenieurs zowel virtuele als realtime versterkingstraining voor hun bots combineren. Ze hopen ook hun robots op te schalen, maar dat zal veel meer experimenteren en verfijnen vergen.

Het team is van mening dat het gebruik van soortgelijke diepe RL-benaderingen voor voetbal, evenals vele andere taken, de bewegingen van tweevoetige robots en de realtime aanpassingsmogelijkheden verder zou kunnen verbeteren. Toch is het onwaarschijnlijk dat u zich al zorgen hoeft te maken over de humanoïde robots van DeepMind op grote voetbalvelden – of op de arbeidsmarkt. Tegelijkertijd is het, gezien hun voortdurende verbeteringen, waarschijnlijk geen slecht idee om je klaar te maken om er op te fluiten.