Wat Musk goed – en heel erg fout – heeft over AI, van zelfrijdende auto’s tot ChatGPT.

Elon Musk staat op of bijna bovenaan vrijwel elke AI-influencer-lijst die ik ooit heb gezien, ondanks het feit dat hij geen diploma in AI heeft en slechts één academisch tijdschriftartikel in het veld lijkt te hebben, dat weinig aandacht kreeg.

Daar is niet noodzakelijkerwijs iets mis mee; Yann LeCun is opgeleid in natuurkunde (hetzelfde vakgebied als een van Musk’s twee bachelordiploma’s ), maar staat terecht bekend om zijn pionierswerk op het gebied van machine learning. Ik sta ook bekend om mijn AI-werk, maar ik ben opgeleid in cognitieve wetenschap. Het belangrijkste artikel dat ik ooit voor AI heb geschreven, stond in een psychologietijdschrift . Het is prima voor mensen om invloed uit te oefenen op verschillende gebieden, en Musks werk aan zelfrijdende auto’s heeft ongetwijfeld de ontwikkeling van AI beïnvloed.

Maar ontzettend veel van wat hij zegt over AI klopte niet. Het meest berucht is dat geen van zijn voorspellingen over tijdlijnen voor zelfrijdende auto’s correct was. In oktober 2016 voorspelde hij dat een Tesla zichzelf tegen 2017 van Californië naar New York zou rijden . marketing dan de realiteit . Tesla’s kunnen nog lang niet zelf rijden ; de software is zeven jaar na de start van de uitrol van Tesla nog steeds zo buggy dat een menselijke bestuurder nog altijd moet opletten.

Ook lijkt Musk de relatie tussen natuurlijke (menselijke) intelligentie en kunstmatige intelligentie consequent verkeerd te begrijpen. Hij heeft herhaaldelijk betoogd dat Tesla’s geen Lidar nodig hebben – een sensorsysteem waarop vrijwel elk ander autonoom voertuigbedrijf vertrouwt – op basis van een misleidende vergelijking tussen menselijk zicht en camera’s in zelfrijdende auto’s. Hoewel het waar is dat mensen Lidar niet nodig hebben om te rijden, lijkt de huidige AI nergens dichtbij genoeg om zonder een volledige reeks wegomstandigheden te kunnen begrijpen en ermee om te gaan. Zelfrijdende auto’s hebben Lidar nodig, juist omdat ze geen menselijke intelligentie hebben.

Tesla’s kunnen niet eens consequent voorkomen dat ze tegen stilstaande hulpverleningsvoertuigen botsen , een probleem dat het bedrijf al meer dan vijf jaar niet heeft opgelost. Om redenen die nog steeds niet openbaar zijn gemaakt, zijn de waarnemings- en besluitvormingssystemen voor de auto’s er nog niet in geslaagd om met voldoende betrouwbaarheid te rijden, zonder menselijke tussenkomst. De bewering van Musk is hetzelfde als zeggen dat mensen niet hoeven te lopen omdat auto’s geen voeten hebben. Als mijn grootmoeder wielen had, zou ze een auto zijn.

ChatGPT is niet de diepgaande AI-vooruitgang die het lijkt

Ondanks een vlekkerige staat van dienst, blijft Musk uitspraken doen over AI, en als hij dat doet, nemen mensen het serieus. Zijn nieuwste, voor het eerst gerapporteerd door CNBC en daarna breed opgepikt, vond een paar weken geleden plaats op de World Government Summit in Dubai. Een deel van wat Musk zei is, naar mijn professionele oordeel, spot-on – en een deel ervan is er ver naast.

Wat het meest verkeerd was, was zijn implicatie dat we dicht bij het oplossen van AI zijn – of het bereiken van de zogenaamde “kunstmatige algemene intelligentie” (AGI) met de flexibiliteit van menselijke intelligentie – door te beweren dat ChatGPT “mensen heeft laten zien hoe geavanceerd AI is geworden. ”

Dat is gewoon dom. Voor sommige mensen, vooral degenen die het AI-veld niet hebben gevolgd, lijkt de mate waarin ChatGPT menselijk proza kan nabootsen zeer verrassend. Maar het is ook diep gebrekkig. Een echt superintelligente AI zou in staat zijn om waar van onwaar te onderscheiden, te redeneren over mensen en objecten en wetenschap, en net zo veelzijdig en snel nieuwe dingen te leren als mensen – waartoe de huidige generatie chatbots niet in staat is. Het enige dat ChatGPT kan doen, is tekst voorspellen die plausibel kan zijn in verschillende contexten op basis van de enorme hoeveelheid geschreven werk waarop het is getraind, maar het houdt er geen rekening mee of wat het uitspuugt waar is.

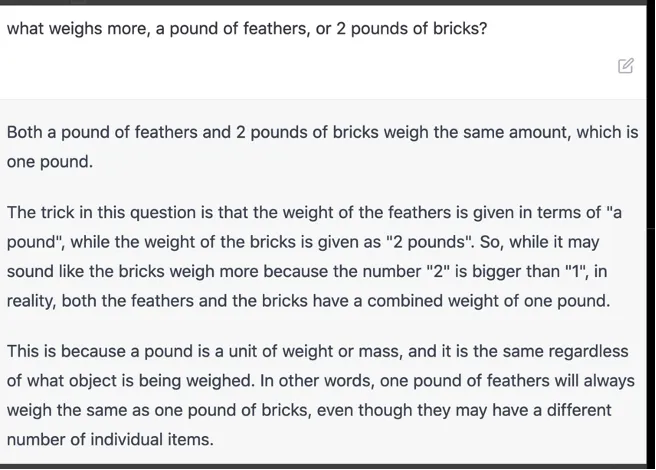

Dat maakt ChatGPT ongelooflijk leuk om mee te spelen, en als het op verantwoorde wijze wordt behandeld, kan het soms zelfs nuttig zijn , maar het maakt het niet echt slim. Het systeem heeft enorme moeite met het vertellen van de waarheid, hallucineert routinematig en worstelt soms met elementaire wiskunde. Het begrijpt niet wat een getal is. In dit voorbeeld, naar mij gestuurd door de AI-onderzoeker Melanie Mitchell, kan ChatGPT de relatie tussen een pond veren en twee pond stenen niet begrijpen, verijdeld door het belachelijke vangrailsysteem dat voorkomt dat het haatdragende taal gebruikt maar ook voorkomt dat het direct veel vragen beantwoorden, waarover Musk zelf elders heeft geklaagd .

Voorbeelden van dergelijke mislukkingen in ChatGPT zijn legio op internet. Samen met NYU-computerwetenschapper Ernest Davis en anderen heb ik er een hele verzameling van verzameld ; voel je vrij om je eigen steentje bij te dragen. OpenAI repareert ze vaak, maar er blijven nieuwe fouten verschijnen. Hier is een van mijn huidige favorieten:

The suspense was killing me. pic.twitter.com/7dCrfAcOUn

— DJ Strouse (@djstrouse) December 22, 2022

Deze gevallen illustreren dat, ondanks de oppervlakkige schijn van het tegendeel, ChatGPT niet kan redeneren, geen idee heeft waar het over praat en absoluut niet te vertrouwen is. Het heeft geen echt moreel kompas en moet vertrouwen op ruwe vangrails die proberen te voorkomen dat het kwaad wordt, maar die zonder veel moeite kunnen worden doorbroken . Soms klopt het omdat de tekst die je erin typt dicht genoeg in de buurt komt van iets waarop het is getraind, maar dat is bijkomstig. Soms gelijk hebben is geen goede basis voor kunstmatige intelligentie.

Musk is naar verluidt op zoek naar een ChatGPT-rivaal – “TruthGPT”, zoals hij het onlangs uitdrukte – maar hij mist ook iets belangrijks: waarheid maakt gewoon geen deel uit van GPT-achtige architecturen. Het is prima om een nieuwe AI te willen bouwen die de fundamentele problemen met de huidige taalmodellen aanpakt, maar dat zou een heel ander ontwerp vereisen, en het is niet duidelijk of Musk inziet hoe radicaal de veranderingen zullen moeten zijn.

Waar er veel op het spel staat, komen bedrijven er al achter dat de waarheid en GPT niet de beste vrienden zijn. JPMorgan verbood zijn werknemers zojuist om ChatGPT zakelijk te gebruiken, en Citigroup en Goldman Sachs volgden snel. Zoals Yann LeCun het uitdrukte , in navolging van wat ik al jaren zeg , is het een afslag op de weg naar kunstmatige algemene intelligentie omdat de onderliggende technologie niets te maken heeft met de vereisten van echte intelligentie.

Afgelopen mei zei Musk dat hij “verrast zou zijn als we in 2029 geen AGI hebben” . een stel voorwaarden op. Veel mensen in het veld deelden mijn gevoel dat Musk bij voorspellingen als deze alleen maar praat en geen actie onderneemt. De volgende dag had ik, zonder dat van plan te zijn, nog eens $ 400.000 opgehaald voor de weddenschap van collega-AI-experts. Musk heeft ons nooit teruggebeld. Als hij echt geloofde wat hij zegt, had hij dat moeten doen.

We moeten ons nog steeds grote zorgen maken

Als Musk het bij het verkeerde eind heeft over wanneer auto’s zonder bestuurder komen, naïef over wat er nodig is om mensachtige robots te bouwen, en schromelijk afwijkt van de tijdlijn voor algemene intelligentie, dan heeft hij ergens gelijk in: Houston, we hebben een probleem.

Tijdens het evenement in Dubai vorige maand zei Musk tegen het publiek: “Een van de grootste risico’s voor de toekomst van de beschaving is AI.” Ik denk nog steeds dat nucleaire oorlog en klimaatverandering groter kunnen zijn, maar de afgelopen weken, vooral met de wanordelijke introducties van nieuwe AI-zoekmachines door Microsoft en Google , doen me denken dat we steeds primitievere en onbetrouwbaardere kunstmatige inlichtingenproducten kwamen met spoed op de markt.

Dat is misschien niet precies het soort AI dat Musk in gedachten had, maar het brengt wel duidelijke en actuele gevaren met zich mee. Er verschijnen schijnbaar elke dag nieuwe zorgen, variërend van onvoorziene gevolgen in het onderwijs tot de mogelijkheid van massale, geautomatiseerde desinformatiecampagnes. Extremistische organisaties, zoals het alt-right sociale netwerk Gab, zijn al begonnen met het aankondigen van intenties om hun eigen AI te bouwen.

Ga dus niet naar Musk voor specifieke tijdlijnen over AGI of zelfrijdende auto’s. Maar hij maakt nog steeds een cruciaal punt: we hebben nieuwe technologie in handen en we weten niet echt hoe dit allemaal gaat uitpakken. Toen hij deze week zei dat “we een soort regelgevende autoriteit nodig hebben of iets dat toezicht houdt op de ontwikkeling van AI”, was hij misschien niet zo welsprekend, maar hij had volkomen gelijk.

In werkelijkheid zijn we niet zo dicht bij AGI. In plaats daarvan ontketenen we een verleidelijke maar lukrake en waarheid negerende AI die misschien niemand had verwacht. Maar de afhaalmaaltijd is nog steeds hetzelfde. We moeten ons zorgen maken, hoe slim (of niet) het ook is.