Het bestuur van OpenAI had wellicht gelijk toen hij Sam Altman ontsloeg – en hem ook opnieuw aannam

Het alternatief – een massale uittocht van OpenAI’s toptalent naar Microsoft – zou erger zijn geweest.

De grote opschudding bij OpenAI – met het ontslag en uiteindelijk het herstel van CEO Sam Altman – kwam voor bijna iedereen als een schok. Maar de waarheid is dat het bedrijf waarschijnlijk altijd een breekpunt zou bereiken. Het werd gebouwd op een breuklijn die zo diep en onstabiel was dat de stabiliteit uiteindelijk plaats zou maken voor chaos.

Die breuklijn was de dubbele missie van OpenAI: AI bouwen die slimmer is dan de mensheid, en er tegelijkertijd voor zorgen dat AI veilig en gunstig voor de mensheid zou zijn. Er bestaat een inherente spanning tussen deze doelen , omdat geavanceerde AI mensen op verschillende manieren schade kan toebrengen, van het verankeren van vooroordelen tot het mogelijk maken van bioterrorisme . Nu lijkt de spanning in het mandaat van OpenAI te hebben bijgedragen aan het bespoedigen van de grootste aardbeving in de technologie-industrie in decennia.

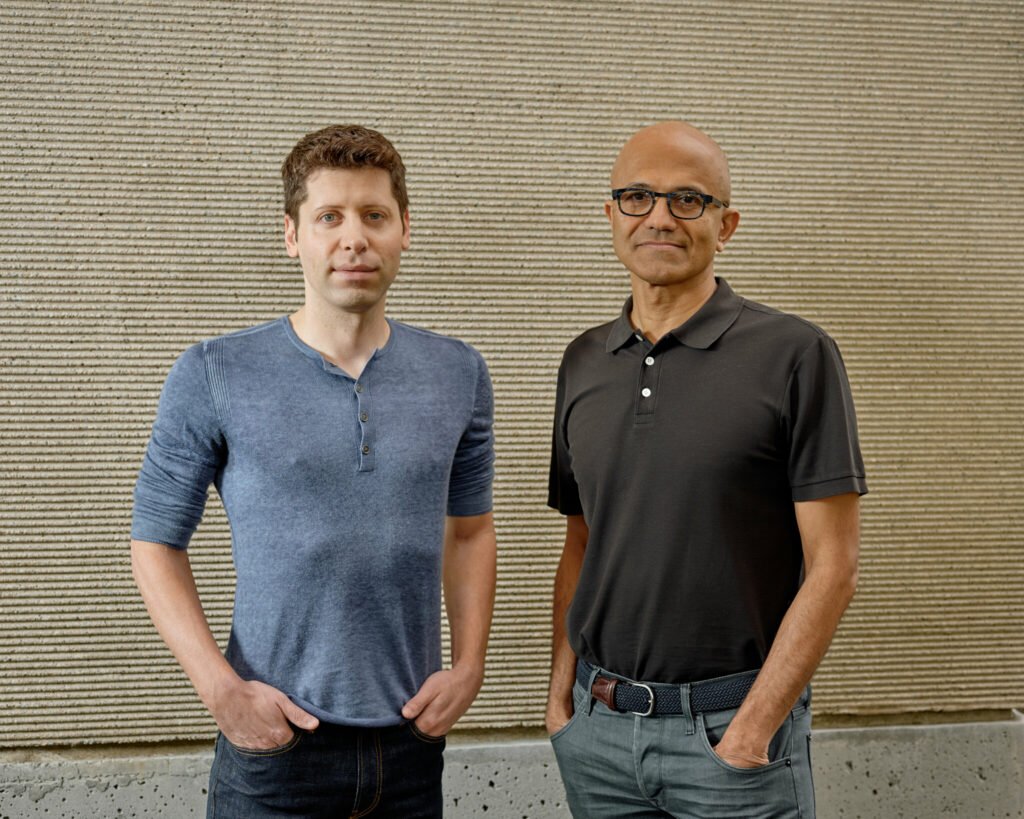

Vrijdag ontsloeg het bestuur Altman vanwege een vermeend gebrek aan transparantie, waarna bedrijfsvoorzitter Greg Brockman uit protest opstapte. Zaterdag probeerde het tweetal het bestuur ertoe te bewegen hen weer aan te stellen, maar de onderhandelingen verliepen niet zoals ze wilden. Zondag hadden ze allebei een baan aanvaard bij de grote OpenAI-investeerder Microsoft , waar ze hun werk op het gebied van geavanceerde AI zouden voortzetten. Maandag dreigde 95 procent van de OpenAI-werknemers ook naar Microsoft te vertrekken.

Dinsdagavond laat maakte OpenAI bekend : “We hebben een principeakkoord bereikt dat Sam Altman terugkeert naar OpenAI als CEO met een nieuw eerste bestuur.”

Hoe chaotisch dit alles ook was, de naschokken voor het AI-ecosysteem hadden nog enger kunnen zijn als de opschudding was geëindigd met een massale uittocht van OpenAI-werknemers, zoals een paar dagen geleden op het punt leek te gebeuren. Een stroom van talent van OpenAI naar Microsoft zou een stroom hebben betekend van een bedrijf dat was opgericht op basis van zorgen over de veiligheid van AI, naar een bedrijf dat nauwelijks de moeite kan nemen om lippendienst aan het concept te bewijzen.

Heeft het bestuur van OpenAI uiteindelijk de juiste beslissing genomen toen het Altman ontsloeg? Of heeft het de juiste beslissing genomen toen het hem opnieuw aannam?

Het antwoord zou op beide wel eens ‘ja’ kunnen zijn.

Het bestuur van OpenAI deed precies wat het moest doen: de integriteit van het bedrijf beschermen

OpenAI is geen typisch technologiebedrijf. Het heeft een unieke structuur, en die structuur is de sleutel tot het begrijpen van de huidige opschudding.

Het bedrijf werd oorspronkelijk opgericht als een non-profitorganisatie die zich in 2015 richtte op AI-onderzoek. Maar in 2019, hongerend naar de middelen die het nodig zou hebben om AGI te creëren – kunstmatige algemene intelligentie, een hypothetisch systeem dat menselijke capaciteiten kan evenaren of overtreffen – creëerde OpenAI een voor- winst entiteit.

Dat stelde investeerders in staat geld in OpenAI te stoppen en er mogelijk rendement uit te halen, ook al zou hun winst beperkt zijn, volgens de regels van de nieuwe opzet, en alles boven de limiet zou terugkeren naar de non-profitorganisatie. Cruciaal was dat het bestuur van de non-profitorganisatie de macht behield om de entiteit met winstoogmerk te besturen. Dat omvatte het inhuren en afvuren van macht.

De taak van het bestuur was ervoor te zorgen dat OpenAI zich aan zijn missie hield, zoals verwoord in zijn charter , waarin duidelijk staat: “Onze primaire fiduciaire plicht is jegens de mensheid.” Niet voor investeerders. Niet aan werknemers. Aan de mensheid.

Het handvest stelt ook: “We zijn bezorgd dat de ontwikkeling van AGI in een laat stadium een competitieve race wordt zonder tijd voor adequate veiligheidsmaatregelen.” Maar het stelt paradoxaal genoeg ook: “Om effectief te zijn in het aanpakken van de impact van AGI op de samenleving, moet OpenAI zich op het snijvlak van AI-mogelijkheden bevinden.”

Dit lijkt veel op het volgende: we maken ons zorgen over een race waarin iedereen zijn best doet om vooraan in het peloton te staan. Maar we moeten vooraan in het peloton staan.

Elk van deze twee impulsen vond een avatar in een van de leiders van OpenAI. Ilya Sutskever, medeoprichter van OpenAI en toponderzoeker op het gebied van AI, maakte zich naar verluidt zorgen dat het bedrijf te snel handelde en probeerde winst te maken ten koste van de veiligheid. Sinds juli geeft hij mede leiding aan het “ Superalignment ”-team van OpenAI, dat tot doel heeft uit te vinden hoe de risico’s van superintelligente AI kunnen worden beheerst.

Altman ging ondertussen met volle kracht vooruit. Onder zijn ambtstermijn deed OpenAI meer dan enig ander bedrijf om een wapenwedloopdynamiek te katalyseren, met name met de lancering van ChatGPT afgelopen november.

Meer recentelijk was Altman naar verluidt bezig met fondsenwerving bij autocratische regimes in het Midden-Oosten, zoals Saoedi-Arabië, zodat hij een nieuw bedrijf voor de productie van AI-chips kon opzetten. Dat op zichzelf zou tot bezorgdheid over de veiligheid kunnen leiden, aangezien dergelijke regimes AI zouden kunnen gebruiken om digitale surveillance of mensenrechtenschendingen een impuls te geven.

We weten nog steeds niet precies waarom het bestuur van OpenAI Altman heeft ontslagen. Het bestuur heeft gezegd dat hij “niet consequent openhartig was in zijn communicatie met het bestuur, waardoor het vermogen van het bestuur om zijn verantwoordelijkheden uit te oefenen werd belemmerd.”

Ook wij hebben jou steun nodig in 2025, gun ons een extra bakkie koffie groot of klein.

Dank je en proost?

Wij van Indignatie AI zijn je eeuwig dankbaar

Sutskever, die het voortouw nam bij de afzetting van Altman, verdedigde de stap aanvankelijk in soortgelijke bewoordingen: “Dit was het bestuur dat zijn plicht deed in het kader van de missie van de non-profitorganisatie, namelijk ervoor zorgen dat OpenAI een AGI opbouwt die de hele mensheid ten goede komt”, vertelde hij aan medewerkers van een bijeenkomst voor alle handen, uren na het afvuren. (Sutskever keerde later echter van kant en zei dat hij spijt had van zijn deelname aan de afzetting.)

“Sam Altman en Greg Brockman lijken van mening te zijn dat het versnellen van AI het meeste goeds voor de mensheid kan bereiken. De pluraliteit van het [oude] bestuur lijkt er echter een andere mening op na te houden dat het tempo van de vooruitgang te snel is en de veiligheid en het vertrouwen in gevaar zou kunnen brengen”, zegt Sarah Kreps, directeur van het Tech Policy Institute aan de Cornell University.

“Ik denk dat het bestuur de enige beslissing heeft genomen die ze dachten te kunnen nemen” door Altman te ontslaan, vertelde AI-expert Gary Marcus me. “Ik denk dat ze iets van Sam hebben gezien waarvan ze dachten dat ze er niet mee konden leven en trouw konden blijven aan hun missie. Dus in hun ogen hebben ze de juiste keuze gemaakt.”

Voordat OpenAI ermee instemde Altman opnieuw aan te stellen, maakte Kreps zich zorgen dat “het bestuur de strijd misschien had gewonnen, maar de oorlog had verloren.”

Met andere woorden: als het bestuur Altman gedeeltelijk ontsloeg omdat hij bang was dat zijn acceleratie-impuls het veiligheidsgedeelte van de missie van OpenAI in gevaar zou brengen, won het de strijd, in die zin dat het deed wat het kon om het bedrijf trouw te houden aan de missie.

Maar als het verhaal was geëindigd met de staatsgreep die het toptalent van OpenAI rechtstreeks in de armen van Microsoft duwde, zou het bestuur de grotere oorlog hebben verloren: de poging om AI veilig te houden voor de mensheid. Wat ons brengt bij…

Het AI-risicolandschap zou waarschijnlijk nog erger zijn als Altman ontslagen was gebleven

Het schieten van Altman veroorzaakte ongelooflijk veel chaos. Volgens futurist Amy Webb, de CEO van het Future Today Institute, was het bestuur van OpenAI er niet in geslaagd ‘strategische vooruitziendheid’ in de praktijk te brengen – om te begrijpen hoe het plotselinge ontslag van Altman ervoor zou kunnen zorgen dat het bedrijf implodeerde en zou kunnen doorwerken in het grotere AI-ecosysteem. ‘Je moet nadenken over de volgende implicaties van je daden’, vertelde ze me.

Het is zeker mogelijk dat Sutskever de dreiging van een massale uittocht die OpenAI helemaal had kunnen beëindigen niet heeft voorspeld. Maar een ander bestuurslid achter de afzetting, Helen Toner – die Altman had gehekeld vanwege een artikel dat zij mede schreef en waarin kritiek leek te worden geuit op OpenAI’s benadering van veiligheid – begreep wel dat dit een mogelijkheid was.

En het was een mogelijkheid die ze bereid was te aanvaarden, als dat de beste bescherming van de belangen van de mensheid zou zijn – wat, vergeet niet, de taak van het bestuur was. Ze zei dat als het bedrijf zou worden vernietigd als gevolg van het ontslag van Altman, dat “in overeenstemming zou kunnen zijn met zijn missie”, meldde de New York Times .

Maar toen Altman en Brockman aankondigden dat ze zich bij Microsoft zouden aansluiten en de OpenAI-staf ook met een massale uittocht dreigde, zou dat de berekening van het bestuur kunnen hebben veranderd: ze in eigen beheer houden was aantoonbaar beter dan dit nieuwe alternatief. Ze rechtstreeks in de armen van Microsoft sturen zou waarschijnlijk niet veel goeds voorspellen voor de veiligheid van AI.

Microsoft heeft immers eerder dit jaar zijn hele AI-ethiekteam ontslagen . Toen Microsoft-CEO Satya Nadella in februari samenwerkte met OpenAI om zijn GPT-4 in Bing Search te integreren, beschimpte hij concurrent Google : “We lieten ze dansen.” En toen hij Altman aannam, tweette Nadella dat hij opgewonden was dat de afgezette leider ‘een nieuw tempo voor innovatie’ zou zetten.

Het naar buiten duwen van het toptalent van Altman en OpenAI zou hebben betekend dat “OpenAI zijn handen kan afwassen van elke verantwoordelijkheid voor mogelijke toekomstige misstappen op het gebied van de AI-ontwikkeling, maar het niet kan tegenhouden”, aldus Kreps. “De ontwikkelingen laten zien hoe dynamisch en riskant de AI-ruimte is geworden, en dat het onmogelijk is om de vooruitgang te stoppen of te beperken.”

Onmogelijk is misschien een te sterk woord. Maar om de vooruitgang in te dammen zou een verandering van de onderliggende stimuleringsstructuur in de AI-industrie nodig zijn, en dat is uiterst moeilijk gebleken in de context van het hyperkapitalistische, hypercompetitieve, snel-en-breek-dingen Silicon Valley. Door voorop te lopen in de technologische ontwikkeling wordt winst en prestige verdiend, maar dat leent zich niet voor vertraging, ook al is vertraging sterk gerechtvaardigd .

Onder Altman probeerde OpenAI deze cirkel rond te maken door te stellen dat onderzoekers met geavanceerde AI moeten spelen om erachter te komen hoe ze geavanceerde AI veilig kunnen maken – dus het versnellen van de ontwikkeling is eigenlijk nuttig. Dat was zelfs tien jaar geleden een vage logica, maar die houdt vandaag de dag geen stand meer, nu we AI-systemen zo geavanceerd en zo ondoorzichtig hebben (denk aan: GPT-4) dat veel experts zeggen dat we eerst moeten uitzoeken hoe ze werken. we bouwen meer zwarte dozen die nog onverklaarbaarder zijn.

OpenAI was ook op een prozaïscher probleem gestuit dat het vatbaar maakte voor een winstbejag pad: het had geld nodig. Om grootschalige AI-experimenten uit te voeren heb je tegenwoordig heel veel rekenkracht nodig – meer dan 300.000 maal zoveel als tien jaar geleden – en dat is ongelooflijk duur. Om voorop te blijven lopen, moest het dus een winstgerichte tak oprichten en samenwerken met Microsoft.

OpenAI was hierin niet de enige: het rivaliserende bedrijf Anthropic , dat voormalige medewerkers van OpenAI hebben opgericht omdat ze zich meer op veiligheid wilden concentreren, begon met te beweren dat we de onderliggende stimuleringsstructuur in de sector moeten veranderen, maar sloot zich uiteindelijk aan bij krachten met Amazon .

Is het, gegeven dit alles, zelfs mogelijk om een AI-bedrijf op te bouwen dat de nieuwste stand van de techniek bevordert en tegelijkertijd echt prioriteit geeft aan ethiek en veiligheid?

‘Het lijkt erop dat dat misschien niet het geval is,’ zei Marcus.

Webb was zelfs nog directer en zei: “Ik denk niet dat het mogelijk is.” In plaats daarvan benadrukte ze dat de overheid de onderliggende stimuleringsstructuur waarbinnen al deze bedrijven opereren moet veranderen. Dat zou een mix van wortelen en stokken omvatten: positieve prikkels, zoals belastingvoordelen voor bedrijven die bewijzen dat ze de hoogste veiligheidsnormen handhaven; en negatieve prikkels, zoals regelgeving.

Intussen is de AI-industrie een Wild West, waar elk bedrijf zijn eigen regels hanteert. OpenAI leeft om nog een dag te spelen.