Een onderzoeksjournalist ontvangt een video van een anonieme klokkenluider. Het toont een kandidaat voor president die toegeeft aan illegale activiteiten. Maar is deze video echt? Als dat zo is, zou het enorm nieuws zijn – de primeur van je leven – en de komende verkiezingen volledig omkeren. Maar de journalist laat de video door een gespecialiseerde tool lopen, die haar vertelt dat de video niet is wat hij lijkt. In feite is het een ” deepfake “, een video gemaakt met behulp van kunstmatige intelligentie met deep learning .

Journalisten over de hele wereld zouden binnenkort zo’n tool kunnen gebruiken. Over een paar jaar zou een dergelijke tool zelfs door iedereen kunnen worden gebruikt om nepinhoud in hun feeds op sociale media te verwijderen.

Als onderzoekers die deepfake-detectie hebben bestudeerd en een tool voor journalisten hebben ontwikkeld, zien we een toekomst voor deze tools. Ze zullen echter niet al onze problemen oplossen en ze zullen slechts een deel zijn van het arsenaal in de bredere strijd tegen desinformatie.

Het probleem met deepfakes

De meeste mensen weten dat je niet alles kunt geloven wat je ziet. In de afgelopen decennia zijn slimme nieuwsconsumenten gewend geraakt aan het zien van afbeeldingen die zijn gemanipuleerd met fotobewerkingssoftware. Video’s zijn echter een ander verhaal. Hollywood-regisseurs kunnen miljoenen dollars uitgeven aan speciale effecten om een realistische scène te maken. Maar met behulp van deepfakes kunnen amateurs met een paar duizend dollar aan computerapparatuur en een paar weken te besteden iets bijna even natuurgetrouw maken.

Deepfakes maken het mogelijk om mensen in filmscènes te plaatsen waar ze nooit in waren – denk aan Tom Cruise die Iron Man speelt – wat zorgt voor vermakelijke video’s. Helaas maakt het het ook mogelijk om pornografie te maken zonder toestemming van de afgebeelde personen. Tot nu toe zijn die mensen, bijna alle vrouwen, de grootste slachtoffers wanneer deepfake-technologie wordt misbruikt.

Deepfakes kunnen ook worden gebruikt om video’s te maken van politieke leiders die dingen zeggen die ze nooit hebben gezegd. De Belgische Socialistische Partij heeft een niet-neppe maar nog steeds nepvideo van lage kwaliteit uitgebracht waarin president Trump België beledigt , die genoeg reacties kreeg om de potentiële risico’s van deepfakes van hogere kwaliteit te laten zien.

Misschien wel het engste van allemaal , ze kunnen worden gebruikt om twijfel te zaaien over de inhoud van echte video’s , door te suggereren dat ze deepfakes kunnen zijn.

Gezien deze risico’s zou het buitengewoon waardevol zijn om deepfakes te kunnen detecteren en duidelijk te labelen. Dit zou ervoor zorgen dat nepvideo’s het publiek niet voor de gek houden en dat echte video’s als authentiek kunnen worden ontvangen.

Vervalsingen spotten

Deepfake-detectie als een onderzoeksgebied is iets meer dan drie jaar geleden begonnen . Het eerste werk was gericht op het detecteren van zichtbare problemen in de video’s, zoals deepfakes die niet knipperen . Na verloop van tijd zijn de vervalsingen echter beter geworden in het nabootsen van echte video’s en worden ze moeilijker te herkennen voor zowel mensen als detectietools.

Ook wij hebben jou steun nodig in 2025, gun ons een extra bakkie koffie groot of klein.

Dank je en proost?

Wij van Indignatie AI zijn je eeuwig dankbaar

Er zijn twee hoofdcategorieën van onderzoek naar diepe vervalsing. De eerste betreft het kijken naar het gedrag van mensen in de video’s. Stel dat je veel video’s hebt van iemand die beroemd is, zoals president Obama. Kunstmatige intelligentie kan deze video gebruiken om zijn patronen te leren, van zijn handgebaren tot zijn spraakpauzes. Het kan dan een diepe vervalsing van hem bekijken en opmerken waar het niet overeenkomt met die patronen. Deze benadering heeft het voordeel dat het mogelijk werkt, zelfs als de videokwaliteit zelf in wezen perfect is.

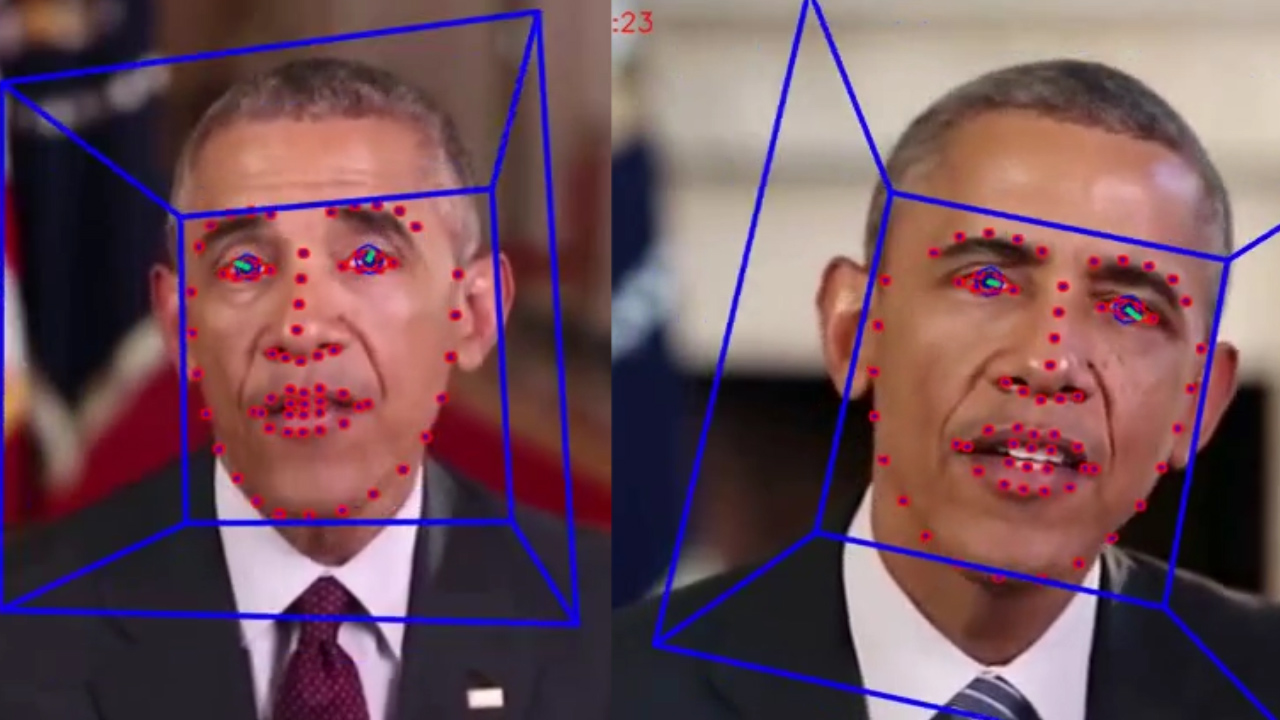

Andere onderzoekers, waaronder ons team , zijn gefocust op verschillen die alle deepfakes hebben vergeleken met echte video’s. Deepfake-video’s worden vaak gemaakt door individueel gegenereerde frames samen te voegen tot video’s. Hiermee rekening houdend, extraheren de methoden van ons team de essentiële gegevens van de gezichten in afzonderlijke frames van een video en volgen ze vervolgens via sets van gelijktijdige frames. Hierdoor kunnen we inconsistenties detecteren in de informatiestroom van het ene frame naar het andere. We gebruiken een vergelijkbare aanpak ook voor ons nep-audiodetectiesysteem.

Deze subtiele details zijn moeilijk te zien voor mensen, maar laten zien dat deepfakes nog niet helemaal perfect zijn . Detectoren zoals deze kunnen voor iedereen werken, niet slechts voor een paar wereldleiders. Uiteindelijk kan het zijn dat beide typen dieptepeilingsdetectoren nodig zijn.

Recente detectiesystemen presteren erg goed op video’s die specifiek zijn verzameld voor het evalueren van de tools. Helaas doen zelfs de beste modellen het slecht op online gevonden video’s . Het verbeteren van deze tools om ze robuuster en nuttiger te maken, is de belangrijkste volgende stap.

[ Ontvang feiten over het coronavirus en het laatste onderzoek. Meld u aan voor de nieuwsbrief van The Conversation. ]

Voor wie is dieptepuntdetector bedoeld?

Idealiter zou een deepfake-verificatietool voor iedereen beschikbaar moeten zijn. Deze technologie bevindt zich echter nog in de beginfase van ontwikkeling. Onderzoekers moeten de tools verbeteren en ze beschermen tegen hackers voordat ze op grote schaal worden vrijgegeven.

Tegelijkertijd zijn de tools om deepfakes te maken beschikbaar voor iedereen die het publiek voor de gek wil houden. Aan de zijlijn zitten is geen optie. Voor ons team was de juiste balans om met journalisten samen te werken, omdat zij de eerste verdedigingslinie zijn tegen de verspreiding van verkeerde informatie.

Journalisten moeten de informatie verifiëren voordat ze verhalen publiceren. Ze hebben al beproefde methoden, zoals het controleren van bronnen en het vragen van meer dan één persoon om de belangrijkste feiten te verifiëren. Dus door de tool in hun handen te geven, geven we ze meer informatie, en we weten dat ze niet alleen op de technologie zullen vertrouwen, aangezien deze fouten kan maken.

Kunnen de detectoren de wapenwedloop winnen?

Het is bemoedigend om te zien dat teams van Facebook en Microsoft investeren in technologie om deepfakes te begrijpen en te detecteren. Dit veld heeft meer onderzoek nodig om gelijke tred te houden met de snelheid van de vooruitgang in de deepfake-technologie.

Journalisten en de sociale mediaplatforms moeten ook uitzoeken hoe ze mensen het beste kunnen waarschuwen voor deepfakes wanneer ze worden gedetecteerd. Uit onderzoek is gebleken dat mensen zich de leugen wel herinneren , maar niet dat het een leugen was. Geldt hetzelfde voor nepvideo’s? Het simpelweg ‘Deepfake’ in de titel zetten is misschien niet genoeg om sommige soorten desinformatie tegen te gaan.

Deepfakes zijn er om te blijven. Het beheren van desinformatie en het beschermen van het publiek zal uitdagender dan ooit zijn, aangezien kunstmatige intelligentie krachtiger wordt. We maken deel uit van een groeiende onderzoeksgemeenschap die deze dreiging aanpakt, waarbij detectie slechts de eerste stap is.