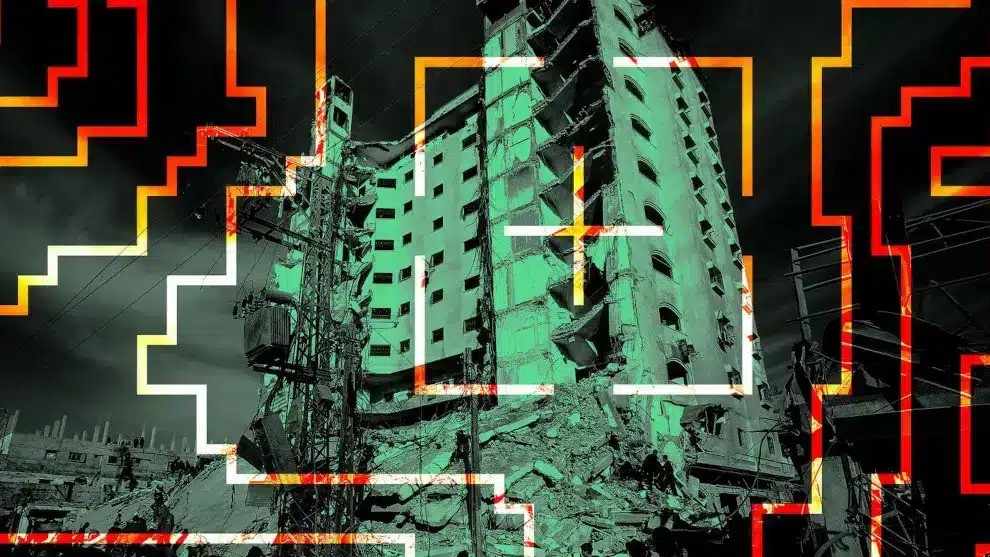

Israël Keer op keer worden we teruggebracht naar de kwestie van de mensheid in de huidige mondiale conflicten. Dit is ook het geval als je hoort hoe het Israëlische leger kunstmatige intelligentie gebruikt om duizenden burgers te liquideren.

Isra├½l Iedereen die nog geen veertig jaar geleden cyberpunkromans heeft gelezen, zal merken dat delen van de hedendaagse realiteit op een soort cosplay lijken. Dat geldt ook voor Lavender, het programma waarbij het Isra├½lische leger doelen zou hebben uitgekozen die vervolgens werden gebombardeerd. Wat┬Ā een paar dagen geleden bekend┬Āwerd over Lavender ┬Āis diep sinister, en er is niet veel fantasie voor nodig om zoŌĆÖn programma te combineren met AI-gestuurde drones en je zit midden in een van de dystopie├½n van die tijd.

Maar Lavendel is geen dystopie, maar een hedendaagse realiteit, en men is verbaasd te ontdekken dat het morele debat over de noodzaak van menselijke verantwoordelijkheid, een van de themaŌĆÖs van cyberpunk, volledig is verdwenen op het moment dat de fantasie├½n van de tijd wordt concrete werkelijkheid is. Dit geldt gedeeltelijk voor de wereld die volledig wordt gecontroleerd door grote bedrijven, waar we nu heel dichtbij zijn (of waarin we ons al bevinden, als je aan Von der Leyen-Pfizer denkt).

Het verhaa l van Lavender, zoals verteld door de Israëlische journalist Yuval Abraham, is even banaal als eng. De Israëlische regering besloot zich te richten op alle leden van de militaire vleugel van Hamas, en het leger ontdekte dat het hen technisch gezien overbelastte omdat het simpelweg te veel gegevens waren. Daar kwam het programma in beeld, dat voorheen alleen als hulpmiddel werd gebruikt omdat het in kortere tijd aanzienlijk meer gegevens kon verwerken.

Twee weken lang werd gecontroleerd of de selectie klopte, daarna werd het gebruik ervan goedgekeurd. “Vanaf dat moment zeiden bronnen dat als Lavender besloot dat een individu een Hamas-strijder was, ze dat in wezen als een bevel moesten behandelen, zonder de verplichting om onafhankelijk te verifi├½ren waarom de machine die keuze maakte of om de gegevens te onderzoeken.” waarop het gebaseerd was.ŌĆØ

In de regel werden deze gemarkeerde doelen vervolgens om vijf uur ’s ochtends gebombardeerd, omdat het gemakkelijker was ze thuis te raken dan onderweg. Het werd aanvaardbaar geacht als 15 tot 20 andere mensen zouden worden gedood terwijl ├®├®n persoon door het programma werd aangezien voor een simpele Hamas-strijder.

Alastair Crooke, een voormalige Britse diplomaat die jarenlang als contactpersoon tussen onder meer de EU en Hamas heeft gewerkt,┬Ā┬Āzei┬Ā┬Ā: ŌĆ£Iedereen is min of meer Hamas in Gaza. Ik bedoel, ik werkte destijds in Gaza en Hamas was dominant, ze hadden de verkiezingen gewonnen, ze waren daar, en iedereen kende iemand van Hamas, iedereen had contact met iemand van Hamas.ŌĆØ En Crooke zei nog iets anders: ŌĆ£Alle belangrijke Hamas-mensen zitten diep in hun bunkers, en ze kunnen niet naar boven komen, je kunt ze niet identificeren met gezichtsherkenning of dat soort dingen, en wat er aan de oppervlakte in Gaza gebeurt, is meestal burgers.ŌĆØ

Lavender verwerkte gegevens van alle 2,3 miljoen inwoners van Gaza en gaf ze allemaal een beoordeling van 1 tot 100. De commandant van de Isra├½lische inlichtingendienst die verantwoordelijk is voor het onderscheppen van inlichtingen zou zelfs een boek hebben geschreven waarin hij de mogelijkheden van een dergelijk programma prijst. en noemt enkele van de criteria die worden gebruikt voor de rangschikking – bijvoorbeeld lidmaatschap van een WhatsApp-groep met een bekende vechter, elke paar maanden van mobiele telefoon wisselen of vaker van adres veranderen.

De vragen bepalen echter de uitkomst, en Abraham legt, onder verwijzing naar zijn bronnen, uit dat dergelijk communicatiegedrag is aangetroffen bij totaal verschillende mensen: politieagenten, medewerkers van de civiele bescherming, familieleden van strijders en bewoners die simpelweg dezelfde bijnaam hadden. Maar inwoners van de Gazastrook die eenvoudigweg een gebruikte mobiele telefoon gebruikten die ooit toebehoorde aan een vermoedelijke strijder, kwamen ook vast te zitten in dit netwerk.

37.000 mensen werden door het programma tijdelijk tot doelwit verklaard. ŌĆ£Bronnen zeiden dat de enige verplichte menselijke controle v├│├│r het bombarderen van de huizen van zogenaamde ŌĆśgewoneŌĆÖ strijders een enkele controle was: ervoor zorgen dat het door de AI gekozen doelwit mannelijk was en niet vrouwelijk.ŌĆØ

De gegevens die Lavender had uitgekozen, werden vervolgens gekoppeld aan trackingprogramma’s zoals de programma’s die ouders gebruiken voor de mobiele telefoons van hun kinderen, en er was een doelwit. Volgens Abraham werden zelfs minderjarigen het doelwit van bombardementen.

Het Isra├½lische leger zou de duurdere, nauwkeurigere bommen hebben bewaard voor hogergeplaatste Hamas-strijders; een ŌĆśdommeŌĆÖ bom was genoeg voor de zogenaamde voetsoldaten. En juist het feit dat het programma zoveel ŌĆśdoelenŌĆÖ opleverde, zorgde ervoor dat er niet te veel aandacht werd besteed aan ├®├®n persoon, laat staan ŌĆŗŌĆŗaan de huisgenoten.

ŌĆ£Er kunnen twintig kinderen zijn voor een simpele vechterŌĆØ, citeerde Abraham een ŌĆŗŌĆŗvan zijn bronnen. Zelfs 300 burgerslachtoffers werden geaccepteerd voor een aanval op een hoge commandant van de militaire vleugel.

Maar uiteindelijk is het niet de vraag of de drempel tien, vijftien of twintig mensenlevens is die worden opgeofferd als ŌĆ£collateral damageŌĆØ, het is zelfs niet de vraag hoe betrouwbaar de selectie gemaakt door een kunstmatige intelligentie kan zijn. Het cruciale punt is nog een opmerking die┬Āwerd opgeworpen┬Ādoor voormalig CIA-analist Larry Johnson┬Ā┬Ā:

ŌĆ£De keuze die wordt gemaakt over wie ze moeten doden, ontslaat de mensen die de keuze maken echter niet van hun morele en juridische verantwoordelijkheid voor de beslissing om te doden.ŌĆØ

En Johnson wijst terecht op de historische voorbeelden die de functie aantonen van het zoveel mogelijk wegnemen van de verantwoordelijkheid bij de executeurs-testamentairen.

ŌĆ£We hebben dit gezien bij de taskforces in de Tweede Wereldoorlog die door Oekra├»ne trokken, waar ze mensen naakt uitkleedden, in loopgraven stopten en neerschoten. Toen ontdekte de leiding van het Duitse leger dat dit enorme psychologische problemen veroorzaakte, dus moesten ze een manier vinden om massa-executies uit te voeren zonder dat er mensen direct bij betrokken waren, en dat is precies wat zich ontwikkelde bij Netanyahu, waar ze feitelijk massa-executies uitvoeren. zonder dat ze zich daadwerkelijk persoonlijk verantwoordelijk voelen, al zijn ze dat natuurlijk wel.ŌĆØ

Het is een bizarre ontwikkeling in de geschiedenis dat waar ooit het proces tegen Adolf Eichmann plaatsvond, die met veel volharding betoogde dat hij alleen maar bevelen had opgevolgd, nu een kunstmatige intelligentie, het ŌĆśdenkenŌĆÖ van een machine, precies de functie vervult die Eichmann had. had en geeft in zijn plaats de bevelen – met dezelfde barbaarse gevolgen. Bovenal moet het duidelijk zijn dat het geen toeval is dat dergelijke structuren, die het mogelijk maken om persoonlijke verantwoordelijkheid op te geven, altijd tot stand zijn gebracht met het precieze doel elke menselijke remming te overwinnen.

Lavendel is een angstaanjagende blik op een mogelijke toekomst. Er is de afgelopen jaren veel te leren over de onnadenkende bereidheid om te gehoorzamen ŌĆō in het hele Westen. En de normen van de mensheid hebben aanzienlijk aan waarde ingeboet. Als dit niet wordt gestopt, als er niet wordt gevochten voor een terugkeer naar verantwoordelijkheid en menselijkheid en als programmaŌĆÖs als Lavender zich verspreiden samen met alle andere mogelijkheden van surveillance, controle en vervolging, zullen de dystopie├½n van cyberpunk opnieuw een vriendelijke hint lijken. Ook op dit punt, met betrekking tot de kwestie van het handhaven van de menselijke verantwoordelijkheid in een tijd waarin het mogelijk is geworden deze af te schaffen, ervaren we momenteel een beschavingsstrijd.