Kunstmatige intelligentie AI kan de bedreigingen voor burgerlijke vrijheden, burgerrechten en privacy vergroten.

AI – Je vrienden zijn niet de enigen die je tweets op sociale media zien. De FBI en het Department of Homeland Security (DHS), evenals politiediensten in het hele land, beoordelen en analyseren de online activiteiten van mensen. Deze programma’s zullen waarschijnlijk alleen maar groeien naarmate generatieve kunstmatige intelligentie (AI) belooft onze online wereld opnieuw te maken met betere, snellere en nauwkeurigere analyses van gegevens, evenals de mogelijkheid om mensachtige tekst, video en audio te genereren.

Hoewel sociale media wetshandhavingsinstanties kunnen helpen bij het onderzoeken van misdaden, reiken veel van deze monitoringinspanningen veel breder, zelfs voordat AI in de mix wordt gebracht. Programma’s gericht op ‘situationeel bewustzijn’, zoals programma’s die worden uitgevoerd door veel delen van het DHS of politiediensten die zich voorbereiden op openbare evenementen, kennen doorgaans weinig waarborgen.

Ze richten zich vaak op het monitoren van sociale en politieke bewegingen, vooral die waarbij minderheidsgemeenschappen betrokken zijn. Het National Operations Center van het DHS heeft bijvoorbeeld meerdere bulletins uitgegeven over de protesten tegen raciale gerechtigheid in 2020. De politie van Boston volgde berichten van Black Lives Matter- demonstranten en bestempelde online toespraken met betrekking tot islamitische religieuze en culturele praktijken als ‘extremistisch’ zonder enig bewijs van geweld of terrorisme.

De wetshandhaving beperkt zich ook niet tot het scannen van openbare berichten. De politie van Memphis heeft bijvoorbeeld een nep-Facebook-profiel gemaakt om vriendschap te sluiten en informatie te verzamelen van Black Lives Matter-activisten.

De alomtegenwoordigheid – en de problemen – van het toezicht op sociale media zullen vrijwel zeker worden verergerd door nieuwe AI-instrumenten…

Interne beoordelingen van de overheid doen ernstige twijfel rijzen over het nut van breed toezicht op sociale media. In 2021, na uitgebreide rapporten over de overdreven reikwijdte van het departement bij het monitoren van demonstranten op het gebied van raciale gerechtigheid, beoordeelde het kantoor van de General Counsel van het DHS de activiteiten van agenten die sociale media en andere open source-informatie verzamelden om te proberen opkomende bedreigingen te identificeren. Het bleek dat agenten materiaal verzamelden over ‘een breed scala aan algemene bedreigingen’, wat uiteindelijk ‘informatie van beperkte waarde’ opleverde.

De regering-Biden heeft opdracht gegeven tot een herziening van het beleid uit het Trump-tijdperk, waarbij bijna alle visumaanvragers hun gegevens op sociale media moeten indienen bij het ministerie van Buitenlandse Zaken, wat jaarlijks ongeveer 15 miljoen mensen treft, om te helpen bij het doorlichten van immigratie – een praktijk die het Brennan Center heeft geprobeerd te bewerkstelligen. uitdaging . Hoewel de resultaten van het onderzoek niet openbaar zijn gemaakt, concludeerden inlichtingenfunctionarissen die belast waren met de uitvoering ervan dat het verzamelen van gegevens uit sociale media “geen waarde” toevoegde aan het screeningproces.

Dit komt overeen met eerdere bevindingen. Volgens een brief uit 2016 , opgesteld door het Department of Homeland Security voor de komende regering, leverde accountinformatie in soortgelijke programma’s voor het onderzoeken van vluchtelingen “geen duidelijke, verwoordbare verbanden op met zorgen over de nationale veiligheid, zelfs niet voor de aanvragers van wie werd vastgesteld dat ze een potentieel gevaar vormden”. bedreiging van de nationale veiligheid op basis van andere resultaten van veiligheidsonderzoek.”

Het jaar daarop gaf de inspecteur-generaal van het DHS een audit van deze programma’s vrij, waarbij werd vastgesteld dat het departement de effectiviteit ervan niet had gemeten en ze een onvoldoende basis had gegeven voor toekomstige initiatieven. Ondanks dat ze er niet in slagen te bewijzen dat monitoringprogramma’s daadwerkelijk de nationale veiligheid bevorderen, blijft de overheid gegevens uit sociale media verzamelen, gebruiken en bewaren.

De alomtegenwoordigheid – en de problemen – van het toezicht op sociale media zullen vrijwel zeker worden verergerd door nieuwe AI-instrumenten, waaronder generatieve modellen, die agentschappen haastig willen adopteren .

Generatieve AI zal wetshandhavers in staat stellen gemakkelijker geheime accounts te gebruiken. In de fysieke wereld hebben undercover-informanten al lang problemen aan de orde gesteld, vooral wanneer ze zijn gebruikt om gemeenschappen op te sporen in plaats van zich op specifieke criminele activiteiten te richten. Online undercoveraccounts zijn veel gemakkelijker en goedkoper te maken en kunnen worden gebruikt om mensen te misleiden tot interactie en onbedoeld persoonlijke informatie te delen, zoals de naam van hun vrienden en verenigingen.

Nieuwe AI-tools kunnen nepaccounts genereren met voldoende interesses en connecties om er echt uit te zien en autonoom online met mensen te communiceren, waardoor agenten tijd en moeite besparen. Dit zal het probleem van moeiteloos toezicht een impuls geven, waarvan het Hooggerechtshof heeft erkend dat het “de relatie tussen burger en overheid kan veranderen op een manier die vijandig is voor de democratische samenleving.”

Deze zorgen worden nog verergerd door het feit dat maar weinig politiediensten beperkingen opleggen aan het gebruik van undercoveraccounts , waarbij veel politiediensten mensen online kunnen monitoren zonder een duidelijke reden, documentatie of toezicht. Hetzelfde geldt voor federale agentschappen zoals het DHS .

Momenteel lijken de surveillance-instrumenten voor sociale media, ondanks de hype die door hun leveranciers wordt gegenereerd, op een relatief rudimentaire basis te werken. Hoewel de bedrijven die ze verkopen vaak geheimzinnig doen over de manier waarop ze werken, wijst het onderzoek van het Brennan Center op ernstige tekortkomingen. Sommige populaire tools maken geen gebruik van wetenschappelijke methoden voor het identificeren van relevante datasets, en testen ze nog minder op vooringenomenheid.

Ze gebruiken vaak sleutelwoorden en zinsneden om potentiële bedreigingen te identificeren , waardoor de context vervaagt die nodig is om te begrijpen of iets inderdaad een bedreiging is en niet, bijvoorbeeld, iemand die een videogame bespreekt. Het is mogelijk dat grote taalmodellen, zoals ChatGPT, deze mogelijkheid zullen bevorderen – of op zijn minst zo zullen worden gezien en verkocht – en een groter gebruik van deze tools zullen stimuleren.

Tegelijkertijd kunnen dergelijke verbeteringen teniet worden gedaan door het feit dat algemeen wordt verwacht dat AI de onbetrouwbare informatieomgeving verder zal vervuilen, waardoor de problemen op het gebied van herkomst en betrouwbaarheid zullen worden verergerd. Sociale media zijn al overspoeld met onnauwkeurige en misleidende informatie. Volgens een MIT-onderzoek uit 2018 is de kans dat vals politiek nieuws 70 procent vaker wordt geretweet dan waarheidsgetrouwe inhoud op X (voorheen Twitter).

Bots en nepaccounts – die al menselijk gedrag kunnen nabootsen – vormen ook een uitdaging; Tijdens de COVID-19-pandemie bleek dat bots desinformatie over de ziekte verspreidden en net zo gemakkelijk valse informatie konden verspreiden die door AI was gegenereerd, waardoor platformgebruikers werden misleid. Generatieve AI maakt het creëren van vals nieuws en valse identiteiten gemakkelijker , wat een negatieve bijdrage levert aan een toch al vervuilde online informatieomgeving. Bovendien heeft AI de neiging om informatie te ‘hallucineren’ of te verzinnen – een schijnbaar onoplosbaar probleem dat alomtegenwoordig is onder generatieve AI-systemen.

Generatieve AI verergert ook al lang bestaande problemen. De belofte van een betere analyse doet niets af aan het verlichten van de kwesties rond het Eerste Amendement die naar voren komen door het monitoren van sociale media. Vooringenomenheid in algoritmische hulpmiddelen is al lange tijd een punt van zorg, variërend van voorspellende politieprogramma’s die zwarte mensen als verdachten behandelen tot praktijken voor inhoudsmoderatie die de islamitische uitlatingen ongunstig beïnvloeden .

Instagram-gebruikers ontdekten bijvoorbeeld onlangs dat het label terrorist aan hun Engelse biografie werd toegevoegd als in hun Arabische biografie het woord ‘Palestijns’, de Palestijnse vlag-emoji en de gebruikelijke Arabische uitdrukking ‘God zij geprezen’ voorkomen.

De noodzaak om deze risico’s aan te pakken staat centraal in het AI-uitvoeringsbesluit van president Biden en in een ontwerpmemorandum van het Office of Management and Budget waarin normen worden uiteengezet voor het gebruik van AI door federale instanties. De OMB-memo identificeert het monitoren van sociale media als een gebruik van AI dat de rechten van individuen beïnvloedt, en vereist daarom dat instanties die deze technologie gebruiken, kritische regels volgen voor transparantie, het testen van de doeltreffendheid en het beperken van vooroordelen en andere risico’s.

Helaas zijn deze verstandige regels niet van toepassing op nationale veiligheids- en inlichtingendoeleinden en hebben ze geen invloed op politiediensten. Maar dat zouden ze wel moeten doen.

‘Big Brother houdt je in de gaten’: AI en de impact ervan op sociale media

Invoering

Kunstmatige Intelligentie (AI) is een technologie die tot doel heeft systemen te bouwen die denken en handelen als mensen. De suggestie is dat AI onze ‘Big Brother’ is geworden – met algoritmen die onze persoonlijke voorkeuren leren kennen en producten aanbevelen die we eerder zullen kopen of video’s die we eerder zullen bekijken; met camera’s en sensoren die elke beweging die we maken in de gaten houden.

Hoewel AI bedoeld is om onze levensstandaard en levenskwaliteit te verbeteren en het risico op menselijke fouten te verminderen, is er grote ruimte voor misbruik. Hier onderzoeken we hoe het gebruik van AI sociale mediaplatforms beïnvloedt, en stellen we stappen voor om dergelijke platforms en consumenten te beschermen, inclusief de rol van de Malaysian Content Code 2022 (Code) bij het reguleren van AI-inhoud.

De impact van AI op sociale mediaplatforms

AI is gebaseerd op ‘deep learning’, waarbij algoritmen worden ‘getraind’ om diep verborgen patronen te herkennen en uiteenlopende datapunten te correleren voor een gewenst resultaat. Socialemediaplatforms zoals Meta, Instagram, TikTok en Twitter gebruiken AI-algoritmen als aanbevelingsmotoren. Op basis van uw surfgedrag en geschiedenis kunnen sociale-mediaplatforms onderscheid maken tussen waar u op klikt, kijkt of koopt.

Het gebruik van AI-algoritmen bevordert echter niet alleen uw voorkeuren, maar ook potentieel schadelijke inhoud. In het Verenigd Koninkrijk bleek de 14-jarige Molly Russell bijvoorbeeld talloze uren aan inhoud over zelfbeschadiging en zelfmoord op Instagram te hebben geconsumeerd voordat ze zelfmoord pleegde (de zaak Molly Russell).

Het algoritme van Instagram helpt gebruikers niet alleen specifieke soorten inhoud te vinden, maar beveelt ook soortgelijke berichten aan de gebruiker aan. Bij haar gerechtelijk onderzoek in oktober 2022 oordeelde de lijkschouwer dat Instagram en andere sociale-mediaplatforms hebben bijgedragen aan haar dood.

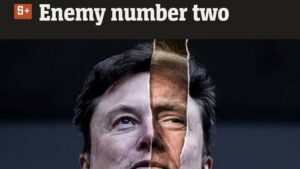

Sociale mediaplatforms vertrouwen ook op gezichtsherkenningssoftware om mensen op foto’s te taggen. Dit heeft aanleiding gegeven tot het gebruik van ‘deepfakes’ en ‘deepfake-technologie’ om afbeeldingen en video’s van nepgebeurtenissen te creëren, nepnieuws te verspreiden, bronnen in diskrediet te brengen en reputaties te vernietigen. De gevaren van deepfakes kunnen niet worden onderschat, omdat het vervaardigen van realistische video’s of nepnieuws door AI potentieel een zero-trust-samenleving kan creëren waarin mensen niet in staat zijn waarheid van leugens te onderscheiden.

Voorgestelde stappen om sociale mediaplatforms en de impact van de Content Code 2022 te beschermen

De Code – bijgewerkt in mei 2022 – heeft tot doel effectieve zelfregulering van de ontwikkeling, productie en verspreiding van inhoud te garanderen, en introduceert duidelijkere richtlijnen over onder meer bedreigende inhoud en valse inhoud. Volgens de Code moet alle zelfmoordgerelateerde inhoud op ethisch en verantwoorde wijze worden gerapporteerd en gedeeld, op basis van best practices en mediarichtlijnen, en de Code verbiedt ook uitdrukkelijk de verspreiding van valse inhoud, dat wil zeggen vals materiaal of onvolledige informatie die waarschijnlijk misleidend is.

De Molly Russell Case illustreert hoe sociale-mediaplatforms aansprakelijk kunnen worden gesteld op basis van de manier waarop hun AI-algoritmen schadelijke inhoud naar voren schuiven. De eigenaren van sociale-mediaplatforms die AI gebruiken, moeten zich door de Code laten leiden en de volgende stappen overwegen:

(a) het implementeren van systemen om redelijkerwijs te voorziene risico’s op schade als gevolg van het platformontwerp te identificeren en het nemen van evenredige stappen om deze risico’s te beperken;

(b) het overwegen van inhoudsmoderatie die geschikt is voor de leeftijd, vooral voor kinderen, en mogelijk het beperken van inhoud die door derden wordt gegenereerd; En

(c) ervoor zorgen dat in advertenties geen verkeerde voorstelling wordt gegeven van zaken die consumenten kunnen beïnvloeden (bijvoorbeeld wanneer adverteerders angstzaaierij gebruiken om consumenten te dwingen bepaalde producten/diensten te kopen).

Hoewel de Code alleen verplicht is voor geselecteerde belanghebbenden in de inhoud- en media-industrie in Maleisië, moeten sociale-mediaplatforms er rekening mee houden dat naleving van de Code een verdediging kan zijn tegen juridische stappen onder de Code en Communications and Multimedia Act 1998 (CMA).

Conclusie

Hoewel AI een destructief vermogen heeft, kan het, als het op de juiste manier wordt beheerd, worden ingezet om betere economische waarde, productiviteit en veiligheid te genereren. Als er geen controle wordt uitgeoefend, kan misbruik van AI-algoritmen leiden tot andere potentiële aansprakelijkheden op grond van de wet, zoals voor oneigenlijk gebruik van netwerkfaciliteiten op grond van Sectie 233 van de CMA.

Landen als Groot-Brittannië en Singapore ondernemen actief stappen om de schade aan gebruikers van sociale-mediaplatforms aan te pakken door strenge wetgeving voor te stellen die de aansprakelijkheid rechtstreeks op deze platforms legt.

In Maleisië worden exploitanten van sociale-mediaplatforms niet alleen door de Code geleid, maar ook aangemoedigd om juridisch advies in te winnen om toekomstige tegenslagen te voorkomen vanwege het gebrek aan juridisch bewustzijn en het risico op schade die zou kunnen ontstaan als gevolg van AI-algoritmen.