Overheden gebruiken al nepdata AI om hun vijanden te verwarren. Wat als ze dit ook in de nucleaire wereld gaan doen?

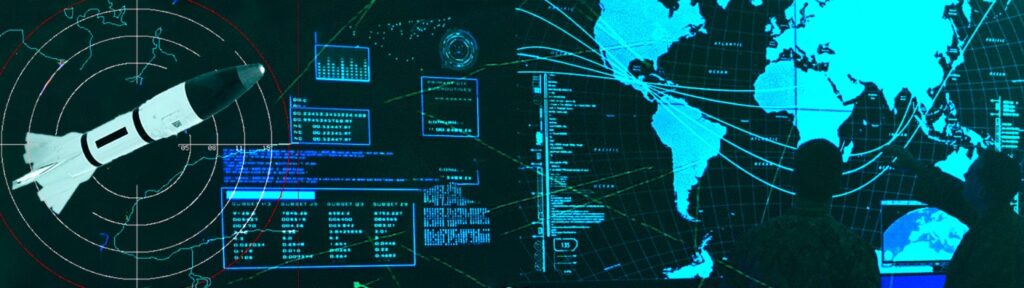

AI militairen zitten in een ondergrondse raketlanceerfaciliteit. Voor hen staat een matrix van knoppen en lampen die rood, wit en groen oplichten. Old-school schermen met blokkerige, volledig in hoofdletters geschreven tekstbalken ernaast. Hun taak is om op elk moment klaar te staan om een nucleaire aanval uit te voeren. Opeens klinkt er een alarm. Het is tijd om hun dodelijke wapen af te vuren.

Met de juiste codes ingevoerd, gaan de deuren naar de raketsilo open en richten een bom op de lucht. Zweet glinstert op hun gezichten. Om de raket te laten vliegen, moeten ze allebei hun sleutels omdraaien. Maar een van hen aarzelt. Hij pakt de telefoon om hun superieuren te bellen.

Dat is niet de procedure, zegt zijn partner. “Laat de procedure maar zitten,” zegt de dissident. “Ik wil iemand aan de telefoon voordat ik 20 miljoen mensen vermoord.”

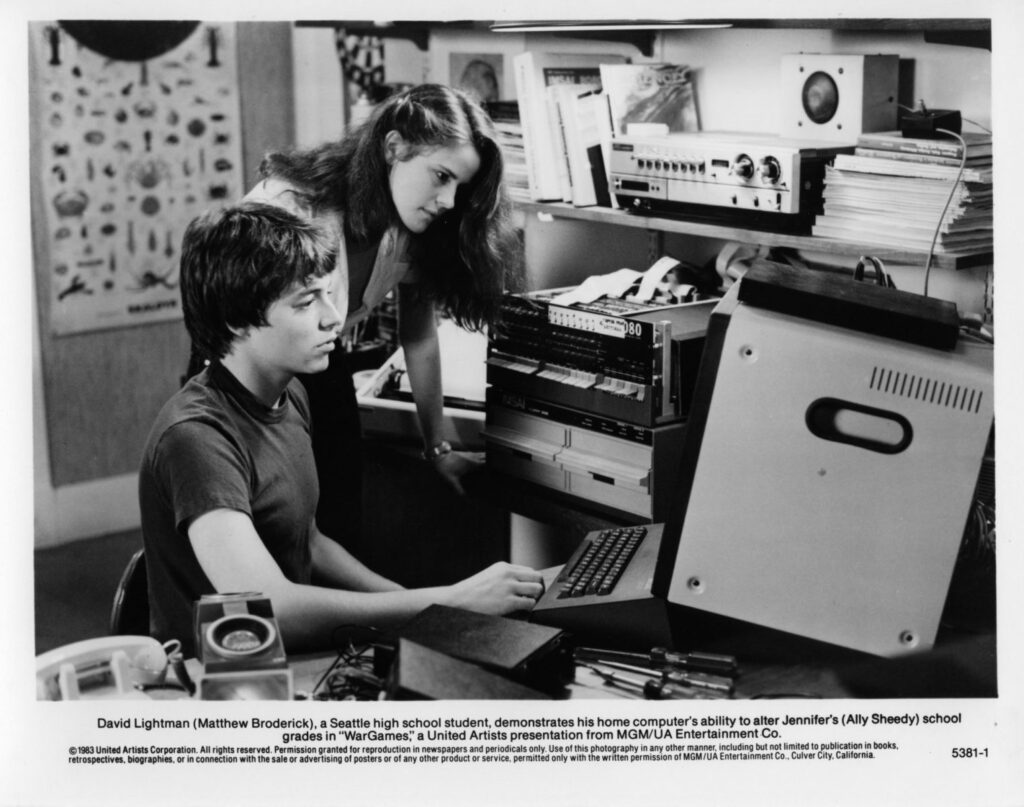

Al snel gaat de scène — die de technothriller “WarGames” uit 1983 opent — over naar een andere set diep in Cheyenne Mountain, een militaire buitenpost begraven onder duizenden meters Colorado graniet. Het bestaat in het echt en wordt gedramatiseerd in de film.

In “WarGames” herbergt de hoofdruimte in Cheyenne Mountain een muur van schermen die de rode, groene en blauwe contouren van continenten en landen tonen, en wat er in de lucht erboven gebeurt. Er is geen sprake van een naderende nucleaire aanval, ondanks wat de militairen is wijsgemaakt: de waarschuwingen waren onderdeel van een test die naar raketcommandanten werd gestuurd om te zien of ze de bevelen zouden uitvoeren. Al met al mislukte 22%.

“Die mannen in de silo’s weten wat het betekent om de sleutels om te draaien,” zegt een functionaris in Cheyenne Mountain. “En sommigen van hen zijn er gewoon niet toe in staat.” Maar hij heeft een idee om die “menselijke reactie” te bestrijden, de impuls om geen miljoenen mensen te doden: “Ik denk dat we de mannen uit de lus moeten halen,” zegt hij.

Vanaf dat moment komt er een kunstmatig intelligent computersysteem in beeld dat bijna twee uur lang voor potentieel wereldvernietigende problemen zorgt.

Het discours over de plot van “WarGames” richt zich meestal op het angstaanjagende idee dat een computer bijna de Derde Wereldoorlog begint door zelf kernwapens af te vuren. Maar de film illustreert een ander probleem dat in de 40 jaar sinds de première steeds urgenter is geworden: de computer toont nepdata over wat er in de wereld gebeurt. De menselijke commandanten geloven dat het authentiek is en reageren dienovereenkomstig.

In de echte wereld zouden landen — of malafide actoren — nepdata kunnen gebruiken, ingevoegd in echte datastromen, om vijanden te verwarren en hun doelen te bereiken. Hoe om te gaan met die mogelijkheid, samen met andere gevolgen van het opnemen van AI in de kernwapensfeer, zou de komende jaren op aarde ingewikkelder kunnen maken.

Het woord “deepfake” bestond nog niet toen “WarGames” uitkwam, maar naarmate echte AI krachtiger wordt, kan het onderdeel worden van de keten van analyse en besluitvorming in het nucleaire rijk van morgen. Het idee van gesynthetiseerde, misleidende data is een AI-kwestie waar het atoomcomplex van vandaag zich zorgen over moet maken.

Je bent de vruchten van deze technologie misschien wel eens tegengekomen in de vorm van Tom Cruise die golf speelt op TikTok, LinkedIn-profielen van mensen die nog nooit op deze wereld hebben gewoond of, nog erger, een video van de Oekraïense president Volodymyr Zelenskyy die de oorlog in zijn land voor beëindigd verklaart. Dit zijn deepfakes: foto’s of video’s van dingen die nooit zijn gebeurd, maar die er verbazingwekkend echt uit kunnen zien.

Het wordt nog erger als AI wordt gebruikt om afbeeldingen te maken die proberen dingen af te beelden die wel degelijk gebeuren. Adobe zorgde onlangs voor ophef door door AI gegenereerde stockfoto’s te verkopen van geweld in Gaza en Israël. De verspreiding van dit soort materiaal (naast veel minder overtuigende dingen) leidt tot de alomtegenwoordige zorg dat elke afbeelding die als feit wordt gepresenteerd, in werkelijkheid gefabriceerd of gewijzigd zou kunnen zijn.

Het maakt misschien niet zoveel uit of Tom Cruise daadwerkelijk op het veld was, maar de mogelijkheid om te zien of te bewijzen wat er in oorlogstijd gebeurt – of er nu een luchtaanval heeft plaatsgevonden op een bepaalde locatie of dat er zich daadwerkelijk troepen of voorraden op een bepaalde plek verzamelen – kan daadwerkelijk invloed hebben op de uitkomsten op de grond.

Vergelijkbare deepfake-creërende technologieën kunnen worden gebruikt om realistisch ogende data te verzamelen — audio, video of afbeeldingen — van het soort dat militaire en inlichtingendiensten verzamelen en dat kunstmatige intelligente systemen al beginnen te analyseren. Het is een zorg voor Sharon Weiner, hoogleraar internationale betrekkingen aan de American University. “Je kunt iemand hebben die probeert je systeem te hacken, niet om het te laten stoppen met werken, maar om onbetrouwbare data in te voegen,” legde ze uit.

James Johnson, auteur van het boek “AI and the Bomb,” schrijft dat wanneer autonome systemen worden gebruikt om beelden te verwerken en te interpreteren voor militaire doeleinden, “synthetische en realistisch ogende data” het moeilijk kunnen maken om te bepalen wanneer er bijvoorbeeld een aanval plaatsvindt.

Mensen zouden AI kunnen gebruiken om data te verzinnen die zijn ontworpen om systemen te misleiden, zoals Project Maven , een programma van het Amerikaanse ministerie van Defensie dat erop gericht is om autonoom beelden en video te verwerken en er betekenis aan te ontlenen over wat er in de wereld gebeurt.

De rol van AI in de nucleaire wereld is nog niet duidelijk. In de VS heeft het Witte Huis onlangs een uitvoerend bevel uitgevaardigd over betrouwbare AI, waarin deels is bepaald dat overheidsinstanties de nucleaire risico’s die AI-systemen met zich meebrengen, moeten aanpakken. Maar probleemscenario’s zoals sommige die door “WarGames” worden opgeroepen, zijn niet onmogelijk.

In de film hackt een tienerhacker het systeem van het leger en start een spel dat hij vindt, genaamd “Global Thermonuclear War”. De computer toont de spelgegevens op de schermen in Cheyenne Mountain, alsof ze van de grond komen. In de oorlogsruimte van Rocky Mountain loeit al snel een sirene: het lijkt erop dat er Sovjetraketten aankomen. Gelukkig rent een ambtenaar in paniek de hoofdruimte binnen. “We worden niet aangevallen,” schreeuwt hij. “Het is een simulatie!”

In de echte wereld zou iemand een aanval eerder kunnen proberen te verhullen met misleidende beelden die rust en stilte uitstralen.

Onderzoekers hebben al aangetoond dat het algemene idee hierachter mogelijk is: wetenschappers publiceerden in 2021 een paper over ‘deepfake geography’, of gesimuleerde satellietbeelden. In dat milieu maakten ambtenaren zich zorgen over beelden die infrastructuur op de verkeerde locatie of terrein zouden kunnen tonen dat niet realistisch is, wat militaire plannen in de war zou brengen.

Wetenschappers van het Los Alamos National Laboratory maakten bijvoorbeeld satellietbeelden met vegetatie die niet echt was en die bewijs van droogte lieten zien waar de waterstanden prima waren, allemaal voor onderzoeksdoeleinden. Je zou theoretisch hetzelfde kunnen doen voor zoiets als troepen- of raketlanceerbewegingen.

AI die nepdata creëert is niet het enige probleem: AI zou ook aan de ontvangende kant kunnen staan, belast met analyse. Dat soort geautomatiseerde interpretatie is al gaande in de inlichtingenwereld, hoewel het onduidelijk is hoe het specifiek zal worden opgenomen in de nucleaire sfeer.

Zo zou AI op mobiele platforms zoals drones kunnen helpen bij het verwerken van data in realtime en “commandanten kunnen waarschuwen voor potentieel verdachte of bedreigende situaties zoals militaire oefeningen en verdachte troepen- of mobiele raketlanceerbewegingen”, schrijft Johnson. Die verwerkingskracht zou ook kunnen helpen bij het detecteren van manipulatie vanwege de mogelijkheid om verschillende datasets te vergelijken.

Maar het creëren van dit soort mogelijkheden kan kwaadwillenden helpen hun bedrog te plegen. “Ze kunnen dezelfde technieken gebruiken die deze AI-onderzoekers hebben gecreëerd, en deze omkeren om bedrog te optimaliseren,” zei Edward Geist, een analist bij de RAND Corporation. Voor Geist is bedrog een “triviale statistische voorspellingstaak.” Maar het herkennen en tegengaan van dat bedrog is waar het moeilijk wordt.

Het omvat een “zeer moeilijk probleem van redeneren onder onzekerheid,” vertelde hij me. Te midden van de over het algemeen hoge inzet van mondiale dynamiek, en vooral in conflict, kunnen landen nooit precies weten wat er gebeurt, wie wat doet en wat de gevolgen van een actie kunnen zijn.

Er is ook kans op vervalsing in de vorm van echte gegevens: satellieten kunnen weliswaar nauwkeurig weergeven wat ze zien, maar wat ze zien is speciaal ontworpen om de geautomatiseerde analysetools te misleiden.

Als voorbeeld wees Geist op de intercontinentale ballistische raketten van Rusland. Wanneer ze stilstaan, zijn ze bedekt met camouflagenetten, waardoor ze moeilijk te onderscheiden zijn op satellietbeelden. Wanneer de raketten in beweging zijn, schieten speciale apparaten die aan de voertuigen die ze vervoeren zijn bevestigd, lasers naar detectiesatellieten, waardoor ze de beweging niet meer zien. Tegelijkertijd worden er lokmiddelen ingezet: nepraketten die zijn vermomd als echte raketten, om af te leiden en analyses te dwarsbomen.

“De nadruk op het gebruik van AI overtreft of overtreft de nadruk die wordt gelegd op tegenmaatregelen”, aldus Weiner.

Aangezien zowel fysieke als AI-gebaseerde misleiding de analyse kan verstoren, kan het op een dag moeilijk worden voor functionarissen om informatie te vertrouwen, zelfs de solide informatie. “De gegevens die u ziet, zijn prima. Maar u gaat ervan uit dat uw tegenstander ze zou vervalsen”, aldus Weiner. “Dan belandt u snel in een spiraal waarin u uw eigen beoordeling van wat u hebt gevonden niet kunt vertrouwen. En dus is er geen uitweg uit dat probleem.”

Vanaf daar is het wantrouwen helemaal naar beneden. “De onzekerheden over AI versterken de onzekerheden die inherent zijn aan elke crisisbesluitvorming,” zei Weiner. Soortgelijke situaties zijn ontstaan in de media, waar het voor lezers moeilijk kan zijn om te bepalen of een verhaal over een bepaalde video — zoals een luchtaanval op een ziekenhuis in Gaza, bijvoorbeeld — echt is of in de juiste context staat. Al snel laten zelfs de echte verhalen lezers twijfelen.

Ook wij hebben jou steun nodig in 2025, gun ons een extra bakkie koffie groot of klein.

Dank je en proost?

Wij van Indignatie AI zijn je eeuwig dankbaar

Meer dan een eeuw geleden zag Alfred von Schlieffen, een Duitse oorlogsplanner, het slagveld van de toekomst voor zich: een persoon die aan een bureau zit met telefoons erop uitgespreid, en van veraf informatie binnenkrijgt. Dit idee van een goddelijk overzicht van conflicten — een samengevoegde visie op wat er gebeurt — is ouder dan computers en AI, aldus Geist.

Het gebruik van computers om informatie in realtime te synthetiseren gaat ook al tientallen jaren terug. In de jaren 50 bouwden de VS bijvoorbeeld het Continental Air Defense Command, dat afhankelijk was van enorme machines (toen bekend als computers) voor bewustzijn en reactie. Maar testen lieten zien dat een meerderheid van de Sovjet-bommenwerpers erdoorheen zou zijn kunnen glippen — vaak omdat ze het verdedigingssysteem konden misleiden met simpele lokmiddelen.

“Het waren de low-tech dingen die het echt belemmerden,” zei Geist. Sommige militaire en inlichtingenfunctionarissen hebben geconcludeerd dat een volgend niveau van situationeel bewustzijn zal komen met slechts een beetje meer technologische vooruitgang dan ze eerder dachten — hoewel dit historisch gezien niet het geval is gebleken. “Deze intuïtie die mensen hebben is zoiets van: ‘Oh, we krijgen alle sensoren, we kopen een grote genoeg computer en dan weten we alles’,” zei hij. “Dit gaat nooit gebeuren.”

Dit soort denken lijkt opnieuw te borrelen en kan in de nabije toekomst opduiken in pogingen om AI te integreren. Maar Geist’s onderzoek, dat hij beschrijft in zijn binnenkort te verschijnen boek “Deterrence Under Uncertainty: Artificial Intelligence and Nuclear Warfare,” laat zien dat het leger “geluk zal hebben als het de mate van situationeel bewustzijn die we vandaag de dag hebben, weet te behouden” als ze meer AI in observatie en analyse opnemen in het licht van AI-verbeterde misleiding.

“Een van de belangrijkste aspecten van intelligentie is redeneren onder onzekerheid”, zei hij. “En een conflict is een bijzonder schadelijke vorm van onzekerheid.” Een op AI gebaseerde analyse, hoe gedetailleerd ook, zal altijd slechts een benadering zijn – en in onzekere omstandigheden is er geen benadering die “gegarandeerd een nauwkeurig genoeg resultaat oplevert om nuttig te zijn.”

In de film wordt de crisis tijdelijk afgewend met de proclamatie dat de Sovjetraketten slechts gesimuleerd zijn. Maar de wargamingcomputer blijft, zonder dat de autoriteiten het weten, doorspelen. Terwijl hij bewegingen blijft maken, toont hij gerelateerde informatie over het conflict op de grote schermen in Cheyenne Mountain alsof het echt is en de raketten op weg zijn naar de Verenigde Staten.

Pas als de uitvinder van de machine opduikt, beginnen de autoriteiten te denken dat dit allemaal nep kan zijn. “Die blips zijn geen echte raketten,” zegt hij. “Het zijn fantomen.”

Om de valse gegevens te weerleggen, wijst de uitvinder op iets dat onbetwistbaar echt is: de aanval op de schermen slaat nergens op. Zo’n grootschalige uitroeiing zou de VS onmiddellijk aanzetten tot totale vergelding — wat betekent dat de Sovjet-Unie bijna haar eigen vernietiging zou verzekeren.

Met zijn eigen oordeel staakt de generaal de Amerikaanse vergelding. Terwijl hij dat doet, raken de raketten op het scherm de 2D-continenten en botsen ze in cirkelvormige flitsen met de kaart. Maar buiten, in de echte wereld, is alles stil. Het was allemaal een spel. “Jezus H. Christus,” zegt een piloot op een basis via het communicatiesysteem. “We zijn er nog steeds.”

Soortgelijke onzinnige waarschuwingen zijn op echte schermen verschenen. In de VS kwamen ooit waarschuwingen voor inkomende raketten binnen vanwege een defecte computerchip. Het systeem waarin de chip zat, stuurde meerdere keren foutieve raketwaarschuwingen.

De autoriteiten hadden reden om te vermoeden dat de gegevens waarschijnlijk vals waren. Maar in twee gevallen begonnen ze te handelen alsof de waarschuwingen echt waren. “Hoewel iedereen leek te beseffen dat het een fout was, volgden ze toch de procedure zonder zich serieus af te vragen wat ze kregen”, aldus Pavel Podvig, senior onderzoeker bij het United Nations Institute for Disarmament Research en onderzoeker aan de Princeton University.

In Rusland hebben operators intussen onafhankelijk nagedacht in een soortgelijk scenario, toen er een foutief voorlopig lanceringscommando werd verzonden. “Slechts één divisiecommandopost doorliep de procedure en deed wat ze moesten doen,” zei hij. “De rest zei: ‘Dit moet een fout zijn’,” omdat het een verrassingsaanval zou zijn geweest die niet voorafgegaan zou zijn door toenemende spanning, zoals verwacht. Het laat zien, zei Podvig, “dat mensen hun oordeel wel of niet gebruiken.”

Je kunt je voorstellen, vervolgde Podvig, dat nucleaire exploitanten in de nabije toekomst een door AI gegenereerde beoordeling kunnen zien die zegt dat de omstandigheden nijpend zijn. In zo’n situatie is er behoefte aan “een bepaald soort gezond verstand in te prenten”, zei hij, en ervoor te zorgen dat mensen niet zomaar alles wat op een scherm verschijnt als evangelie beschouwen. “De basisveronderstellingen over scenario’s zijn ook belangrijk”, voegde hij toe. “Ga je er bijvoorbeeld vanuit dat de VS of Rusland zomaar raketten kunnen afvuren?”

Mensen zullen voorlopig waarschijnlijk nog steeds hun oordeel vellen over aanvallen en reacties, waarbij ze, zoals het jargon luidt, ‘een mens op de hoogte houden’.

Het idee om AI te vragen beslissingen te nemen over of een land kernraketten zal lanceren, is volgens Geist geen aantrekkelijke optie, hoewel het wel vaak in films voorkomt. “Mensen bewaken deze voorrechten jaloers voor zichzelf”, aldus Geist.

“Het lijkt erop dat er niet veel vraag is naar een Skynet”, zei hij, verwijzend naar een andere film, “Terminator”, waarin een kunstmatige algemene superintelligentie een nucleaire aanval op de mensheid uitvoert.

Podvig, een expert op het gebied van de Russische nucleaire activiteiten, ziet niet veel animo voor autonome nucleaire operaties in dat land.

“Er heerst een cultuur van scepsis over al die mooie technologische spullen die naar het leger worden gestuurd,” zei hij. “Ze houden van simpele dingen.”

Geist was het daarmee eens. Hoewel hij toegaf dat Rusland niet helemaal transparant is over zijn nucleaire commando en controle, ziet hij niet veel interesse om de teugels aan AI over te dragen.

China is uiteraard over het algemeen erg geïnteresseerd in AI, en dan met name in de ontwikkeling van algemene kunstmatige intelligentie, een type AI dat kan leren om intellectuele taken net zo goed of zelfs beter uit te voeren dan mensen.

William Hannas, hoofdanalist bij het Center for Security and Emerging Technology aan de Georgetown University, heeft open-source wetenschappelijke literatuur gebruikt om ontwikkelingen en strategieën in de AI-arena van China te traceren. Een grote ontwikkeling is de oprichting van het Beijing Institute for General Artificial Intelligence, gesteund door de staat en geleid door voormalig UCLA-professor Song-Chun Zhu, die miljoenen dollars aan financiering van het Pentagon heeft ontvangen , ook na zijn terugkeer naar China.

Hannas beschreef hoe China een nationale interesse heeft getoond in het “bewerkstelligen van een fusie van menselijke en kunstmatige intelligentie, metaforisch gezien, in de zin van het vergroten van de wederzijdse afhankelijkheid, en letterlijk via door de hersenen geïnspireerde AI-algoritmen en hersen-computerinterfaces.”

“Een echte fysieke samensmelting van intelligentie vindt plaats wanneer je daadwerkelijk wordt vastgeketend aan de computerbronnen tot het punt dat het echt niet meer te onderscheiden is”, zei hij.

Dat is relevant voor defensiediscussies, omdat er in China weinig scheiding is tussen regulier onderzoek en het leger. “Technologische macht is militaire macht”, zei hij. “De een wordt de ander in een heel, heel korte tijd.” Hannas weet echter niet van AI-toepassingen in het ontwerp of de levering van kernwapens in China.

Onlangs ontmoetten de Amerikaanse president Joe Biden en de Chinese president Xi Jinping elkaar en maakten plannen om de veiligheid en risico’s van AI te bespreken, wat zou kunnen leiden tot een overeenkomst over het gebruik van AI in militaire en nucleaire zaken. Ook werden in augustus de regels voor generatieve AI, ontwikkeld door de Chinese Cyberspace Administration, van kracht, waardoor China een first mover werd in de wereldwijde race om AI te reguleren.

Het is waarschijnlijk dat de twee landen AI zouden gebruiken om te helpen met hun enorme stromen van early-warning data. En net zoals AI kan helpen met interpretatie, kunnen landen het ook gebruiken om die interpretatie te verdraaien, om te misleiden en te vertroebelen. Alle drie de taken zijn eeuwenoude militaire tactieken — nu simpelweg geüpgraded voor een digitaal, onstabiel tijdperk.

Sciencefiction overtuigde ons ervan dat een Skynet zowel een waarschijnlijke optie was als dichterbij de horizon dan het in werkelijkheid is, zei Geist. AI zal waarschijnlijk op veel banalere manieren worden gebruikt. Maar de ideeën die “WarGames” en “Terminator” domineren, hebben het lang volgehouden.

“De reden dat mensen dit verhaal blijven vertellen is dat het een geweldig uitgangspunt is,” zei Geist. “Maar het is ook zo,” voegde hij toe, “dat er in feite niemand is die dit als een geweldig idee ziet.”

Het is waarschijnlijk zo resonerend omdat mensen de neiging hebben om een zwart-wit begrip van innovatie te hebben. “Er zijn veel mensen die er heel erg van overtuigd zijn dat technologie ons gaat redden of verdoemen”, zei Nina Miller, die voorheen werkte bij het Nuclear Threat Initiative en momenteel doctoraalstudent is aan het Massachusetts Institute of Technology.

Het idee van een door AI veroorzaakt doemscenario leeft en bloeit in de populaire verbeelding en heeft ook zijn stempel gedrukt op publieke discussies over de AI-industrie. In mei ondertekenden tientallen tech-CEO’s een open brief waarin ze verklaarden dat “het beperken van het risico op uitsterven door AI een wereldwijde prioriteit zou moeten zijn”, zonder veel te zeggen over wat dat precies betekent.

Maar zelfs als AI ooit een kernwapen afvuurt (of valse informatie verstrekt die leidt tot een atoomaanval), dan nog steeds namen mensen de beslissingen die ons daarheen leidden. Mensen creëerden de AI-systemen en maakten keuzes over waar ze die zouden gebruiken.

En bovendien, in het geval van een hypothetische catastrofe, creëerde AI niet de omgeving die leidde tot een nucleaire aanval. “De onderliggende politieke spanning is toch het probleem,” zei Miller. En dat is te danken aan mensen en hun verlangen naar dominantie — of hun motivatie om te bedriegen.

Misschien moeten de mensen leren wat de computer deed aan het einde van “WarGames.” “De enige winnende zet,” zo concludeert het, “is niet spelen.”

Waarom hebben we dit verhaal geschreven?

AI-gegenereerde deepfakes zouden binnenkort de communicatie van militaire inlichtingendiensten kunnen beïnvloeden. In lijn met onze focus op autoritarisme en technologie, duikt dit verhaal in de mogelijke gevolgen die kunnen ontstaan als AI zijn weg vindt naar de nucleaire arena.