Buitenlandse media beïnvloedingscampagnes, of informatieoperaties, zijn wijdverbreid geweest in de aanloop naar de Amerikaanse presidentsverkiezingen van 2024. Beïnvloedingscampagnes zijn grootschalige pogingen om de publieke opinie te veranderen, valse verhalen te verspreiden of gedragingen te veranderen onder een doelgroep. Rusland , China , Iran , Israël en andere landen hebben deze campagnes uitgevoerd door gebruik te maken van sociale bots , influencers , mediabedrijven en generatieve AI .

Bij het Indiana University Observatory on Social Media bestuderen mijn collega’s en ik invloedcampagnes en ontwerpen we technische oplossingen – algoritmen – om deze te detecteren en tegen te gaan. State-of-the-art methoden die in ons centrum zijn ontwikkeld, gebruiken verschillende indicatoren van dit type online activiteit, dat onderzoekers inauthentiek gecoördineerd gedrag noemen. We identificeren clusters van sociale media-accounts die op een gesynchroniseerde manier posten, dezelfde groepen gebruikers versterken, identieke sets links, afbeeldingen of hashtags delen of verdacht vergelijkbare reeksen acties uitvoeren .

We hebben veel voorbeelden van gecoördineerd onecht gedrag ontdekt. We vonden bijvoorbeeld accounts die het netwerk overspoelen met tienduizenden of honderdduizenden berichten op één dag. Dezelfde campagne kan een bericht plaatsen met één account en vervolgens andere accounts die de organisatoren ook beheren, honderden keren ‘liken’ en ‘niet leuk vinden’ in een korte tijdspanne. Zodra de campagne haar doel bereikt, kunnen al deze berichten worden verwijderd om detectie te ontwijken . Met behulp van deze trucs kunnen buitenlandse overheden en hun agenten algoritmen voor sociale media manipuleren die bepalen wat trending is en wat boeiend is om te bepalen wat gebruikers in hun feeds zien.

Generatieve AI

Een techniek die steeds vaker wordt gebruikt, is het creëren en beheren van legers nepaccounts met generatieve kunstmatige intelligentie. We analyseerden 1.420 nepaccounts van Twitter (nu X) die AI-gegenereerde gezichten gebruikten voor hun profielfoto’s. Deze accounts werden gebruikt om onder andere scams te verspreiden, spam te verspreiden en gecoördineerde berichten te versterken.

We schatten dat er dagelijks minstens 10.000 van dit soort accounts actief waren op het platform, en dat was voordat X CEO Elon Musk de vertrouwens- en veiligheidsteams van het platform drastisch inperkte . We identificeerden ook een netwerk van 1.140 bots die ChatGPT gebruikten om mensachtige content te genereren om nepnieuwswebsites en cryptocurrency-oplichting te promoten.

Naast het posten van door machines gegenereerde content, schadelijke opmerkingen en gestolen afbeeldingen, gingen deze bots met elkaar en met mensen om via reacties en retweets. De huidige state-of-the-art detectoren voor grote taalmodellen zijn niet in staat om onderscheid te maken tussen AI-enabled social bots en menselijke accounts in het wild.

Ook wij hebben jou steun nodig in 2025, gun ons een extra bakkie koffie groot of klein.

Dank je en proost?

Wij van Indignatie AI zijn je eeuwig dankbaar

Model wangedrag

De gevolgen van dergelijke operaties zijn moeilijk te evalueren vanwege de uitdagingen die het verzamelen van gegevens en het uitvoeren van ethische experimenten met zich meebrengt die online gemeenschappen zouden beïnvloeden. Daarom is het bijvoorbeeld onduidelijk of online beïnvloedingscampagnes de verkiezingsuitslagen kunnen beïnvloeden . Toch is het van vitaal belang om de kwetsbaarheid van de samenleving voor verschillende manipulatietactieken te begrijpen.

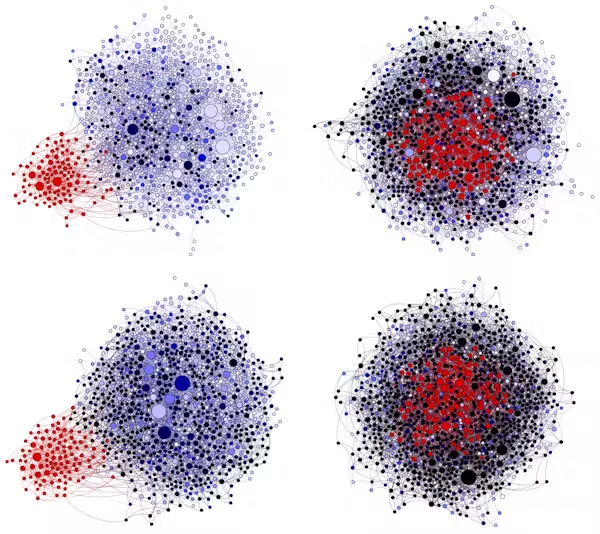

In een recent artikel introduceerden we een social media model genaamd SimSoM dat simuleert hoe informatie zich verspreidt via het sociale netwerk . Het model heeft de belangrijkste ingrediënten van platforms zoals Instagram, X, Threads, Bluesky en Mastodon: een empirisch volgersnetwerk, een feedalgoritme, deel- en herdeelmechanismen en statistieken voor contentkwaliteit, aantrekkingskracht en betrokkenheid.

Met SimSoM kunnen onderzoekers scenario’s onderzoeken waarin het netwerk wordt gemanipuleerd door kwaadwillende agenten die niet-authentieke accounts beheren. Deze kwaadwillenden willen informatie van lage kwaliteit verspreiden, zoals desinformatie, complottheorieën, malware of andere schadelijke berichten. We kunnen de effecten van vijandige manipulatietactieken schatten door de kwaliteit van de informatie te meten waaraan beoogde gebruikers in het netwerk worden blootgesteld.

We hebben scenario’s gesimuleerd om het effect van drie manipulatietactieken te evalueren. Ten eerste, infiltratie: nepaccounts geloofwaardige interacties laten creëren met menselijke gebruikers in een doelgemeenschap, waardoor die gebruikers hen gaan volgen. Ten tweede, misleiding: de nepaccounts boeiende content laten posten, die waarschijnlijk door de doelgebruikers wordt gedeeld. Bots kunnen dit doen door bijvoorbeeld emotionele reacties en politieke voorkeuren te benutten. Ten derde, flooding: grote hoeveelheden content posten.

Ons model laat zien dat infiltratie de meest effectieve tactiek is, die de gemiddelde kwaliteit van content in het systeem met meer dan 50% vermindert. Dergelijke schade kan nog verder worden vergroot door het netwerk te overspoelen met content van lage kwaliteit, maar die toch aantrekkelijk is, waardoor de kwaliteit met 70% afneemt.

Het beteugelen van gecoördineerde manipulatie

We hebben al deze tactieken in het wild waargenomen. Vooral zorgwekkend is dat generatieve AI-modellen het voor kwaadwillende agenten veel gemakkelijker en goedkoper kunnen maken om geloofwaardige accounts te maken en beheren. Verder kunnen ze generatieve AI gebruiken om non-stop met mensen te communiceren en schadelijke maar boeiende content op grote schaal te maken en te posten. Al deze mogelijkheden worden gebruikt om de netwerken van gebruikers van sociale media te infiltreren en hun feeds te overspoelen met misleidende posts.

Deze inzichten suggereren dat socialemediaplatforms meer – en niet minder – content moeten modereren om manipulatiecampagnes te identificeren en te voorkomen en zo de weerbaarheid van hun gebruikers tegen dergelijke campagnes te vergroten.

De platforms kunnen dit doen door het voor kwaadwillende agenten moeilijker te maken om nepaccounts aan te maken en automatisch te posten. Ze kunnen ook accounts die met een hoge frequentie posten, uitdagen om te bewijzen dat ze menselijk zijn. Ze kunnen frictie toevoegen in combinatie met educatieve inspanningen, zoals gebruikers aansporen om nauwkeurige informatie opnieuw te delen . En ze kunnen gebruikers informeren over hun kwetsbaarheid voor misleidende door AI gegenereerde content.

Open-source AI-modellen en -data maken het voor kwaadwillende agenten mogelijk om hun eigen generatieve AI-tools te bouwen. Regelgeving zou daarom gericht moeten zijn op de verspreiding van AI-content via socialemediaplatforms in plaats van op de generatie van AI-content. Voordat een groot aantal mensen bijvoorbeeld aan bepaalde content kan worden blootgesteld, kan een platform eisen dat de maker ervan de nauwkeurigheid of herkomst ervan bewijst.

Deze typen contentmoderatie zouden de vrije meningsuiting op de moderne openbare pleinen beschermen in plaats van censureren . Het recht op vrije meningsuiting is geen recht op blootstelling, en aangezien de aandacht van mensen beperkt is, kunnen beïnvloedingsoperaties in feite een vorm van censuur zijn door authentieke stemmen en meningen minder zichtbaar te maken.